Komunikacja bezprzewodowa i sieci komórkowe 6G

Wyjaśnienie widma 6G - fale radiowe, fale mm, fale sub 6 i pasmo niskie

KOMUNIKACJA MOBILNA SZÓSTEJ GENERACJI (6G)

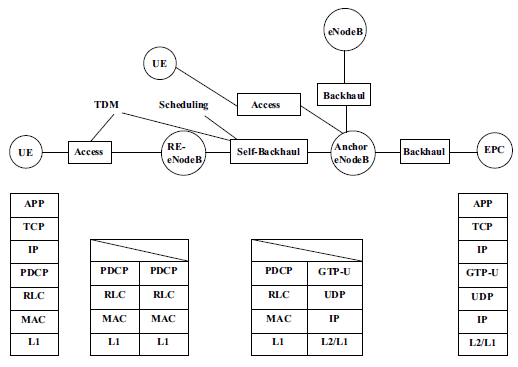

Rozwój komunikacji mobilnej/bezprzewodowej przeszedł przez proces 1G/2G/3G/4G i wszedł w krytyczny etap komercyjnego rozwoju 5G. Z historycznej perspektywy rozwoju przemysłu, system komunikacji mobilnej był aktualizowany co dziesięć lat. Rosnące zapotrzebowanie na komunikację użytkowników i innowacje technologii komunikacyjnych są siłą napędową rozwoju komunikacji mobilnej. Jednak 5G nie spełni wszystkich wymagań przyszłości roku 2030 i późniejszych. Naukowcy zaczynają obecnie skupiać się na komunikacji mobilnej szóstej generacji (6G) sieci. Niektóre kraje i organizacje już rozpoczęły eksplorację technologii 6G wraz z rozpoczęciem komercyjnego wdrażania 5G w głównych krajach na całym świecie.

NIEUCHRONNOŚĆ BADAŃ 6G

Zasada 10-letniego cyklu

Od wprowadzenia systemu komunikacji mobilnej pierwszej generacji (1G) w 1982 roku, nowa generacja systemów bezprzewodowej komunikacji mobilnej była aktualizowana mniej więcej co 10 lat. Od badań koncepcyjnych do zastosowań komercyjnych upływa około 10 lat . Innymi słowy, kiedy poprzednia generacja wchodzi w okres komercyjny, następna generacja rozpoczyna badania koncepcyjne i techniczne. Badania 5G rozpoczęły się 10 lat temu, a obecnie badania 6G są zgodne z prawem rozwoju systemów komunikacji mobilnej. Nadejście 6G może zająć około dziesięciu lat, ale badań nad 6G nie można opóźniać. Komunikacja mobilna będzie dążyć w kierunku ery 6G.

"Efekt suma"

"Efekt suma" oznacza, że aktywuje również zdolność przetrwania małych ryb, gdy sum zakłóca środowisko życia małych ryb. Jest to przyjęcie środków lub środków stymulujących przez niektóre przedsiębiorstwa do aktywności i inwestycji na rynku, aby aktywnie uczestniczyć w konkurencji, co spowoduje aktywację przedsiębiorstw w tej samej branży na rynku. 5G różni się od poprzednich generacji systemów komunikacji mobilnej głównie ukierunkowanych na scenariusze aplikacji IoT / przemysłu pionowego. Wielu przedstawicieli branży pionowej z pewnością będzie uczestniczyć w ekosystemie 5G wraz z wdrożeniem sieci 5G na dużą skalę. Głęboki udział wschodzących firm (zwłaszcza firm internetowych zrodzonych z innowacyjnego myślenia) w przyszłości będzie miał ogromny wpływ na tradycyjny przemysł komunikacyjny, a nawet rewolucyjny wpływ w porównaniu ze status quo zdominowanym przez tradycyjnych operatorów, co nazywane jest "efektem suma".

Wybuchowy potencjał modeli biznesowych IoT

IoT to nieuchronność internetu od góry do dołu w przemyśle. Jest to rozszerzenie od środka na zewnątrz, z platformą chmury jako centrum. Podobnie jak pojawienie się smartfonów stymulowało aplikacje 3G i wywołało zapotrzebowanie na wdrożenie na dużą skalę 4G, uważa się, że niektóre modele biznesowe IoT również będą stymulować przemysł 5G, aby wybuchnąć w pewnym momencie ery 5G, co będzie stymulować przyszłe potrzeby sieci 6G. Aby dostosować się do rygorystycznych wymagań ich perspektywicznych zastosowań, musimy mieć wystarczająco dużo wyobraźni. Musimy zawczasu przygotować się na ewentualne przyszłe sieci i stworzyć dobre podstawy techniczne. Na podstawie powyższej analizy możemy wyciągnąć wniosek, że teraz jest właściwy czas na rozpoczęcie badań nad systemem bezprzewodowej komunikacji mobilnej następnej generacji.

Wydajność 5G ograniczyłaby nowe aplikacje IoT

Pomimo silnego przekonania, że 5G będzie wspierać podstawowe aplikacje IoT związane z MTC i URLLC, można się spierać, czy możliwości systemów 5G zdołają nadążyć za szybkim mnożeniem się ostatecznie nowych aplikacji IoT. Tymczasem, w następstwie rewolucyjnych zmian w trendach indywidualnych i społecznych, oprócz zauważalnego postępu w technologiach interakcji człowiek-maszyna, przewiduje się, że do 2030 r. potrzeby rynku będą świadkami penetracji nowego spektrum usług IoT. Usługi te zapewniają ultra-wysoką niezawodność, ekstremalnie wysokie prędkości danych i ultraniskie opóźnienia jednocześnie w uplink i downlink [6]. Bezprecedensowe wymagania narzucone przez te usługi spowodują, że wydajność systemów 5G zostanie doprowadzona do granic możliwości w ciągu 10 lat od jego uruchomienia. Co więcej, usługi te nalegają, aby 6G być w stanie uwolnić pełny potencjał obfitych usług autonomicznych obejmujących zarówno przeszłe, jak i pojawiające się trendy.

MIĘDZYNARODOWA ORGANIZACJA NORMALIZACYJNA

Międzynarodowy Związek Telekomunikacyjny (ITU)

Zgodnie z planem prac ITU, spotkanie RA-19 w 2019 r. nie ustali nowej rezolucji w sprawie badań technicznych IMT. Wskazuje, że cykl badawczy od 2019 do 2023 roku nadal dotyczy głównie badań technologii 5G i B5G, ale 6G badania nad wizją i trendami technologicznymi będą prowadzone od 2020 do 2023 roku. Główne firmy w branży generalnie uważają, że bardziej odpowiednie jest ustanowienie nowej generacji badań nad technologią IMT i rozwiązania problemu nazewnictwa na spotkaniu RA-23 w 2023 roku. ITU-T SG13 (International Telecommunication Union Telecommunication Study Group 13) powołała ITU-T Focus Group Technologies for Network 2030 (FG NET-2030) na posiedzeniu w lipcu 2018 roku. FG NET-2030 zamierza określić wymagania dla sieci roku 2030 i nie tylko. Prace badawcze nad 6G zostały przeprowadzone podczas ITU-R WP5D (34. spotkanie Grupy Roboczej 5D Sektora Komunikacji Radiowej Międzynarodowego Związku Telekomunikacyjnego), które odbyło się w lutym 2020 r., w tym opracowanie harmonogramu badań 6G, raportów z badań nad przyszłymi trendami technologicznymi oraz pisanie propozycje wizji technologii przyszłości.

Projekt partnerski trzeciej generacji (3GPP)

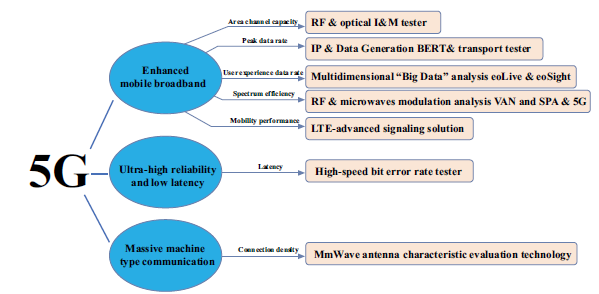

3GPP jest głównym promotorem i integratorem specyfikacji technicznych systemów komunikacyjnych, zarządzającym pracami normalizacyjnymi, takimi jak wprowadzanie wymagań dotyczących systemu komunikacyjnego, projektowanie architektury systemu, bezpieczeństwo i zarządzanie siecią. 3GPP zakończyło opracowywanie pierwszej wersji międzynarodowego standardu 5G Release 15 (R15), skupiając się na wspieraniu scenariuszy ulepszonych mobilnych usług szerokopasmowych oraz scenariuszy ultra wysokiej niezawodności i małych opóźnień w czerwcu 2018 roku. Opracowanie pełnego międzynarodowego standardu 5G Release 16 (R16) zostanie ukończony jesienią 2020 r., co w pełni wesprze trzy scenariusze aplikacji określone przez ITU. Ponadto 3GPP promuje badania nad 6G i działania normalizacyjne. Wydanie 3GPP 17 (R17) rozpoczęło badanie zaawansowanych funkcji, które ukształtują ewolucję w kierunku 6G, a znacząca międzynarodowa standaryzacja 6G ma rozpocząć się w 2025 r.

Instytut Inżynierów Elektryków i Elektroników (IEEE)

Aby lepiej podsumować i uporządkować powiązane technologie sieci nowej generacji, firma IEEE uruchomiła inicjatywę IEEE 5G w grudniu 2016 r. i zmieniła jej nazwę na IEEE Future Networks w sierpniu 2018 r., aby umożliwić 5G i przyszłe sieci. IEEE opracowuje również odpowiednie standardy 5G, które mają zostać przedłożone ITU do zatwierdzenia w 2020 r. Obecnie IEEE zorganizowało kilka seminariów technicznych 6G. Bezprzewodowy szczyt 6G będzie organizowany przez IEEE w marcu każdego roku, a pierwszy bezprzewodowy szczyt 6G został zainicjowany przez IEEE w Holandii 25 marca 2019 r. Przedstawiciele branży i środowiska akademickiego zostali zaproszeni do opublikowania najnowszych informacji na temat 6G. Omówiono teoretyczne i praktyczne wyzwania, z którymi należy się zmierzyć, aby zrealizować wizję 6G. Globalna wizja badawcza 6G, wymagania i potencjalne podejścia zostały opublikowane w białych księgach 6G pod koniec czerwca 2020 r.

POSTĘP BADAWCZY 6G W NIEKTÓRYCH KRAJACH/REGIONACH

Komunikacja 6G jest wciąż w powijakach. Można powiedzieć, że wyścig 6Gresearch ze środowisk akademickich rozpoczął się w marcu 2019 r., kiedy pierwszy szczyt 6G Wireless odbył się w Levi w Finlandii. Niektórzy badacze zdefiniowali również 6G jako B5G lub 5G+. W niektórych krajach/regionach rozpoczęto już wstępne działania badawcze. Prezydent USA poprosił o wdrożenie 6G w tym kraju. Chiny rozpoczęły już studium koncepcyjne dotyczące rozwoju i standaryzacji komunikacji 6G w 2019 roku. Większość krajów europejskich, Japonia i Korea planuje kilka projektów 6G.

Unia Europejska

W 2017 r. Unia Europejska zainicjowała konsultacje dotyczące projektów badawczo-rozwojowych w zakresie technologii 6G, których celem jest zbadanie kluczowych technologii dla komunikacji mobilnej nowej generacji. Fińska działalność badawcza 6G jest koordynowana przez Uniwersytet w Oulu w 2018 r., gdzie uruchomiono inicjatywę 6G. Wstępne założenia UE dla 6G są takie, że szczytowa prędkość powinna być większa niż 100 Gbit/s, przepustowość pojedynczego kanału może osiągnąć 1 GHz, a pasmo częstotliwości teraherców powinno być wyższe niż 275 GHz. Unia Europejska uruchomiła w 2019 roku trzyletni projekt badawczy w zakresie podstawowej technologii 6G. Głównym zadaniem jest zbadanie kodowania korekcji błędów nowej generacji, zaawansowanych technologii kodowania kanałów i modulacji stosowanych w sieciach 6G. Poza tym UE zainicjowała również szereg terahercowych projektów badawczo-rozwojowych. UE wymieniła rozwój komunikacji terahercowej jako program badawczy 6G. Grupa badawcza oparta na unijnym projekcie Terranova pracuje obecnie nad niezawodnym połączeniem 6G z przepustowością 400 Gbit na sekundę w paśmie terahercowym.

Stany Zjednoczone

FCC (Federalna Komisja Łączności Stanów Zjednoczonych) uruchomiła w 2015 r. usługę CBRSD (Public Wireless Broadband Service) w paśmie częstotliwości 3,5 GHz, która dynamicznie zarządza różnymi rodzajami ruchu bezprzewodowego za pośrednictwem scentralizowanego systemu bazy danych dostępu do widma w celu poprawy wydajności wykorzystania widma. Eksperci z FCC zaproponowali trzy kluczowe technologie 6G na szczycie "Mobile World Congress 2018-North America" we wrześniu 2018 r., w tym nowe widmo (pasmo częstotliwości terahercowych), wielkoskalową technologię multipleksowania przestrzennego (obsługa danych setek bardzo wąskich wiązek) oraz technologia dynamicznego współdzielenia widma oparta na blockchain. Ponadto FCC ogłosiło, że w marcu 2019 r. otworzy pasmo częstotliwości terahercowych (95 GHz-3 THz) do wykorzystania w testach technologii 6G, tym samym ustanawiając Stany Zjednoczone jako wyznacznika tempa w wyścigu badawczym 6G.

Japonia

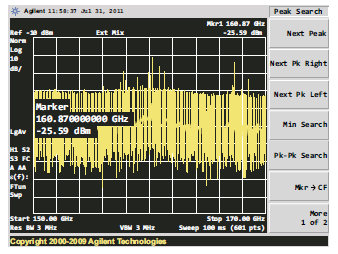

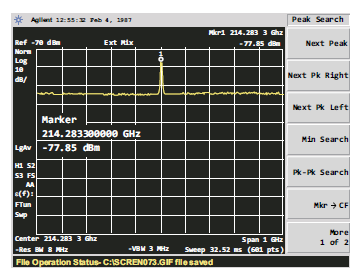

Nihon Keizai Shimbun poinformował, że w lipcu 2018 r. japońska grupa NTT z powodzeniem opracowała nowe technologie dla B5G i 6G. Jedną z nich jest technologia Orbital Angular Momentum (OAM). Zrealizował nałożoną transmisję 11 fal radiowych, które są kilkakrotnie większe niż 5G. Technologia OAM wykorzystuje okrągłą antenę do obracania fal radiowych w spiralę w celu transmisji. Ze względu na właściwości fizyczne duża liczba obrotów utrudni transmisję. NTT planuje w przyszłości zrealizować superpozycję 40 fal radiowych. Drugim jest technologia komunikacji terahercowej. Rozwój technologii terahercowej znajduje się na szczycie "dziesięciu kluczowych celów strategicznych technologii filarów krajowych". Zaproponowano budżet w wysokości ponad 1 miliarda jenów w roku podatkowym 2019 na rozpoczęcie badań nad technologią 6G. Szczytowa prędkość transmisji dochodzi do 100 Gbit/s. Japonia wciąż boryka się z problemem ekstremalnie krótkich odległości transmisji, ale prędkość transmisji może osiągnąć nawet 5 razy większą niż 5G. Japonia przygotowuje 2 miliardy dolarów na wsparcie badań branżowych nad technologią 6G. NTT i Intel zdecydowały się nawiązać współpracę, aby pracować nad technologią sieci 6Gmobile. Ponadto w ramach projektu UE-Japonia w ramach programu Horizon2020 ICT-09-2017 o nazwie "Badania sieciowe wykraczające poza 5G" zbadano również możliwość wykorzystania widma THz od 100 do 450 GHz.

Korea Południowa

Eksperci z Centrum Badawczo-Rozwojowego ICT SK Telecom zaprezentowali 3 technologie dla przyszłych sieci 6G na seminarium technologicznym, które odbyło się na Uniwersytecie Nowojorskim w październiku 2018 r., w tym komunikację terahercową i architekturę bezkomórkową (w pełni zwirtualizowane anteny na dużą skalę RAN+) i inne niż naziemna sieć bezprzewodowa . Samsung Electronics i SK Telecom współpracują nad rozwojem technologii i modeli biznesowych związanych z 6G. Firma LG Electronics utworzyła centrum badawcze 6G we współpracy z Koreańskim Zaawansowanym Instytutem Nauki i Technologii. Ponadto SK telecom zawarł porozumienie z dwoma producentami sprzętu, Ericssonem i Nokią, w celu wspólnego opracowania technologii 6G. W kwietniu 2019 r. koreańscy operatorzy osiągnęli prędkość pobierania 193~430 Mb/s w paśmie częstotliwości 3,5 GHz (sub-6GHz).

Chiny

Pod koniec 2017 roku Chiny rozpoczęły badania nad systemem komunikacji mobilnej 6G, aby sprostać niestałym i bogatym wymaganiom Internetu Rzeczy w przyszłości, takim jak obrazowanie medyczne, rzeczywistość rozszerzona i wykrywanie. Oprócz rozwiązania problemów komunikacji bezprzewodowej między ludźmi i bezprzewodowego dostępu do Internetu, konieczne jest również rozwiązanie problemu komunikacji między rzeczami i rzeczami oraz między ludźmi i rzeczami wraz z rozszerzeniem wykorzystania komunikacji mobilnej w przyszłości. Technologia komunikacji 6G promuje głównie rozwój IoT. Chińskie Ministerstwo Nauki i Technologii (MSTC) zadeklarowało swój cel, jakim jest bycie liderem na rynku komunikacji bezprzewodowej w latach 30. XX wieku poprzez rozszerzenie inwestycji badawczych w 6G oraz wydało zawiadomienie w sprawie rocznych wytycznych dotyczących składania wniosków do kluczowych projektów specjalnych w 2018 roku, takich jak "Szerokopasmowe Communications and New Networks" dla kluczowego krajowego planu badań i rozwoju, z których 5 obejmuje B5G/6G. W 2019 r. MSTC zaplanowało również powołanie dwóch grup roboczych które prowadzą działalność badawczą 6G: pierwsza pochodzi z departamentów rządowych w celu promowania badań i rozwoju 6G, druga składa się z 37 uniwersytetów, instytutów badawczych i firm, koncentrując się na technicznej stronie 6G.

SKŁAD WIDMA 6G

Wymagania dotyczące widma dla 6G

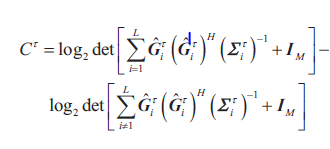

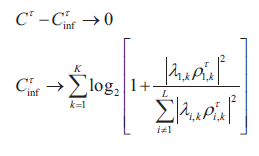

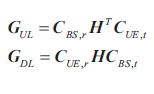

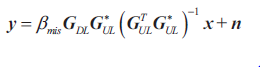

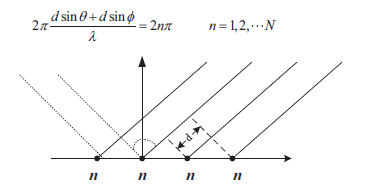

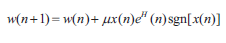

Nasze społeczeństwo stanie się oparte na danych ze względu na prawie brak opóźnień czasowych połączeń bezprzewodowych do około 2030 r. Dlatego oczekuje się, że 6G będzie wykorzystywane do promowania rozwoju technologii bezprzewodowych, które znamy dzisiaj. I oczekuje się, że osiągnie całkiem niezłą wydajność systemu. Na rysunku przedstawiono streszczenie rozwijającej się generacji bezprzewodowej komunikacji komórkowej.

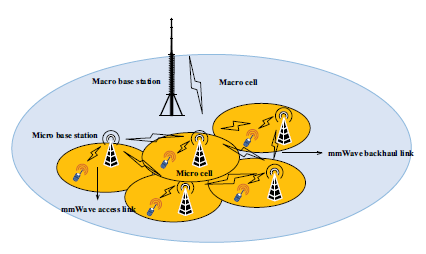

W szczególności pokazano widmo częstotliwości wykorzystywane przez różne generacje systemów komunikacji mobilnej. W celu zwiększenia szybkości transmisji danych od 100 do 1000 razy szybciej niż 5G pod względem widma częstotliwości, 6G może wykorzystywać wyższe widmo częstotliwości niż poprzednie generacje jako wizję na przyszłość. 4G i poprzednie systemy komunikacji mobilnej wykorzystują pasmo częstotliwości Sub-6 GHz, podczas gdy system komunikacji mobilnej 5G wykorzystuje zarówno pasmo częstotliwości Sub-6 GHz (pasmo FR1, 450 MHz-6 GHz), jak i pasmo częstotliwości 24-100 GHz (pasmo FR2, 24,25 GHz-52,6 GHz) . Naukowcy zdają sobie sprawę, że chociaż 5G rozszerza pasmo widma, obecne pasmo częstotliwości wciąż nie wystarcza, aby zaspokoić rosnące zapotrzebowanie na usługi komunikacyjne w szybko rozwijającym się społeczeństwie ludzkim. Dlatego w badaniu sieci 6G rozważymy zasoby widma powyżej 100 GHz, takie jak fala milimetrowa (mmWave) i teraherc (THz), aby zwiększyć przepustowość transmisji. System komunikacji bezprzewodowej 6G będzie wykorzystywać wielopasmowe i szerokopasmowe widmo w celu zwiększenia szybkości transmisji. Ostateczną wizją jest, aby szybkość transmisji od końca do końca osiągnęła setki gigabitów. Oczekuje się, że w przyszłości 6G, naziemna sieć telefonii komórkowej, system satelitarny i Internet połączą się w dużą sieć kosmos-powietrze-ziemia-morze. W związku z tym widmo 6G musi wspierać zintegrowaną komunikację kosmos-powietrze-ziemia-morze. Większość częstotliwości operacyjnych dla łączności kosmos-powietrze-ziemia-morze jest przydzielanych przez Międzynarodowy Związek Telekomunikacyjny (ITU). Pasma mmWave mogą być używane zarówno w kanałach kosmos-ziemia, powietrze-ziemia, jak i kosmos-powietrze.

SUB-6

Pasma Sub-6 GHz były podstawową częstotliwością roboczą w trzeciej generacji, 4G i 5G ze względu na szerokie możliwości pokrycia i niski koszt, które są również niezbędne w 6G.

Widmo niskich częstotliwości

Dodano widmo 6 GHz

Jak mówi powiedzenie: "Pojedynczy drut nie może tworzyć nici, a pojedyncze drzewo nie może tworzyć lasu". Rozwój 5G wymaga nie tylko dużej ilości zasobów widma, ale także współpracy w zakresie wysokich, średnich i niskich częstotliwości. Podczas Światowej Konferencji Komunikacji Radiowej w 2019 r. (WRC-19) osiągnięto globalny konsensus w sprawie pasma częstotliwości fal milimetrowych 5G, aby zaspokoić potrzeby biznesowe systemów 5G w zakresie bardzo dużej pojemności i szybkiej transmisji. Jednocześnie, aby rozwiązać problem dużego i głębokiego zasięgu systemów 5G i osiągnąć lepszą równowagę między przepustowością sieci a zasięgiem, wiele krajów koncentruje się na ciągłym widmie 5G w średnich i niskich pasmach częstotliwości. Nowe zasady użytkowania IMT (5G lub 6G) dla pasma częstotliwości 6GHz (5925 MHz-7125 MHz) znalazły się w agendzie WRC-23 wraz z energiczną promocją chińskiej delegacji na WCR-19. 6425 MHz-7025 MHz staje się nowym regionalnym (kraje arabskie, Afryka, Europa, kraje WNP) pasmem częstotliwości IMT i 7025 MHz-7125 MHz staje się nowym globalnym pasmem częstotliwości IMT. Zasoby widma są cenne i rzadkie jako podstawowe źródło rozwoju technologii komunikacji mobilnej. Planowanie widma jest punktem wyjścia dla branży, a także określi kierunek rozwoju, rytm i model branży. Pomyślne ustanowienie nowego przydziału IMT dla widma 6 GHz oznacza, że pasmo częstotliwości 6 GHz stanie się potencjalnym pasmem częstotliwości dla IMT (5G lub 6G). Kraje na całym świecie dadzą pierwszeństwo temu pasmu częstotliwości przy budowie 5G systemów i przyszłych systemów 6G, co promuje badania i rozwój technologii IMT dla pasma 6 GHz oraz internacjonalizację łańcucha przemysłowego, a także przyspiesza proces globalnych badań i rozwoju komercyjnych 5G i 6G.

Pojemność i zasięg

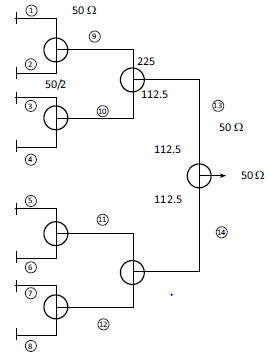

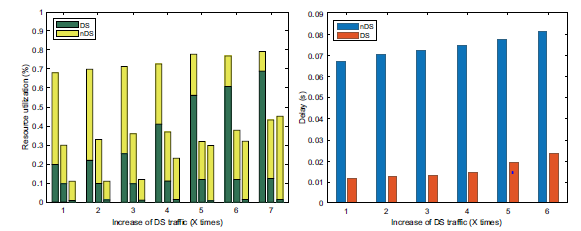

Nowe aplikacje biznesowe 5G spowodowały gwałtowny wzrost wykorzystania danych mobilnych wraz z dalszym przyspieszeniem komercyjnego wykorzystania 5G. Ulepszone mobilne usługi szerokopasmowe, stacjonarne bezprzewodowe usługi szerokopasmowe oraz aplikacje przemysłowe, takie jak inteligentne miasta i produkcja przemysłowa, przyspieszyły wzrost wykorzystania danych mobilnych. Zgodnie z raportem z analizy branżowej, miesięczne wykorzystanie danych na użytkownika na niektórych wiodących rynkach osiągnie 150 GB w 2025 r. Niewątpliwie wymaga to dużej ilości widma radiowego do obsługi. Pasma niskiej i średniej częstotliwości mogą zapewnić ciągłą przepustowość rzędu 100 MHz i dobry zasięg sieci w porównaniu z pasmem częstotliwości fal milimetrowych. Ponadto można wziąć pod uwagę wymagania wydajnościowe dotyczące przepustowości i zasięgu sieci, a koszty budowy sieci można znacznie zmniejszyć. Ponadto charakterystyka propagacji i modele kanałów w pasmach poniżej 6 GHz zostały szeroko zbadane w 5G. Dlatego są ważnymi częściami widma 5G lub 6G. Jako jeden z pionierów w opracowywaniu i wdrażaniu systemów 5G, chiński dział zarządzania radiotelefonami zobowiązał się do poszukiwania większej liczby zasobów częstotliwości IMT dla 5G lub przyszłych technologii 6G, aby wspierać przyszłe technologie i aplikacje z perspektywy efektywnego wykorzystania częstotliwości i długo- planowanie terminów. Zgodnie z charakterystyką każdego pasma częstotliwości, widmo Sub-6 GHz będzie brać pod uwagę wymagania dotyczące zasięgu i przepustowości, co jest idealnym kompromisem między szybkością szczytową a możliwościami pokrycia. Widmo częstotliwości powyżej 6GHz może zapewnić bardzo duże pasmo, większą pojemność i wyższą prędkość, ale zdolność ciągłego pokrycia jest niewystarczająco pokazana na rysunku.

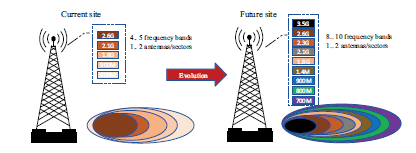

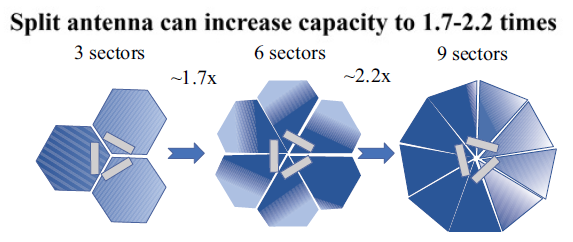

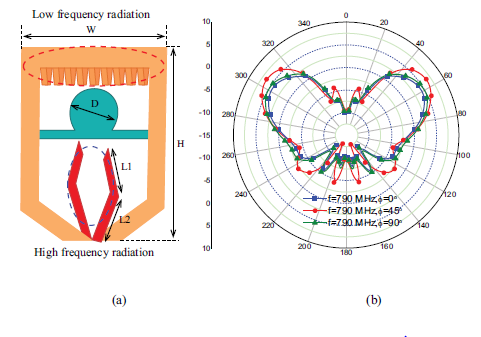

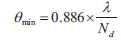

Infrastruktura bezprzewodowa 5G dla częstotliwości Sub-6 GHz będzie szeroko wdrażana przy użyciu rozwiązania kształtowania wiązki, które może znacznie zwiększyć zasięg sieci i możliwości penetracji w budynkach. Pasma niskich częstotliwości (takie jak 600 MHz, 700 MHz, 800 MHz, 900 MHz, 1,5 GHz, 2,1 GHz, 2,3 GHz i 2,6 GHz) charakteryzują się szerokim zasięgiem i niskimi kosztami, które są wykorzystywane w przyszłości na dużą skalę IoT, automatyka przemysłowa i kluczowe zadanie IoT. Bezprzewodowa przepustowość i pojemność wykażą gwałtowny wzrost wraz z dalszym przyspieszeniem sieci komórkowych. Powyższe formowanie wiązki 24 GHz mmWave jest również uważane za obiecującą technologię zapewniającą ultrawysoką przepustowość w zasięgu 6G.

Przydział widma Sub-6

Widmo dla 5G NR

Zasób widma od 1,7 GHz do 4,7 GHz to widmo Sub-6 GHz przydzielone do 5G NR przez 3GPP, które jest pasmem FR1, a maksymalne stale przydzielone widmo wynosi 100 MHz [13]. Poniżej znajduje się wprowadzenie do kilku głównych pasm FR1. n77 (3300 MHz-4200 MHz) i n78 (3300 MHz-3800 MHz) to obecnie najbardziej ujednolicone pasma częstotliwości dla 5G NR na świecie. n79 (4400 MHz-5000 MHz) jest również używany w 5G NR promowanym głównie przez Chiny, Rosję i Japonię. n28 (700 MHz) jest również wysoko ceniony ze względu na dobry zasięg. To pasmo częstotliwości zostało zidentyfikowane jako pionierskie pasmo częstotliwości dla globalnej komunikacji mobilnej na WRC-15. Jeśli to pasmo nie może być w pełni wykorzystane, szkoda. Obecnie amerykański operator T-Mobile zapowiedział wykorzystanie n71 (600 MHz) do budowy 5G. Najbardziej skomplikowane jest wykorzystanie obszarów pasma 3,4 GHz-3,8 GHz. Na przykład w Stanach Zjednoczonych pasmo częstotliwości 3,5 GHz jest wykorzystywane w usługach Citizen Broadcast Radio Service (CBRS), podczas gdy zakres częstotliwości 150 MHz jest wykorzystywany do komunikacji radarowej. Ponadto pasmo częstotliwości może być również wykorzystywane do innych usług komercyjnych wykorzystujących dostęp dynamiczny. Ta dynamiczna metoda dostępu oszczędza użytkownikom drogie licencje na widmo, wystarczy zapłacić odpowiednie opłaty komunikacyjne do dostawcy usług.

Wybór widma systemów

Technologia pasma częstotliwości bez licencji upraszcza proces i ogranicza użytkownikom możliwość łączenia się z siecią. Niemniej jednak, ze względu na istnienie w sieci tych nielicencjonowanych użytkowników widma, niezawodność i bezpieczeństwo sieci bezprzewodowej zostaną zakłócone. W obszarze widma Sub-6 GHz najbardziej godne uwagi nielicencjonowane widma to pasma 2,4 GHz i 5 GHz, które są obecnie dwoma pasmami częstotliwości o najwyższym stopniu wykorzystania. Wśród nich zasoby przepustowości w paśmie 2,4 GHz są ograniczone i zostały wyprzedane przez istniejące usługi, przez co są bardzo zatłoczone. W porównaniu z 2,4 GHz dostępna częstotliwość pasma 5 GHz jest szersza. Ale wraz z rozwojem bezprzewodowych sieci komunikacyjnych spodziewano się, że w najbliższych latach zostanie również wykorzystane pasmo 5 GHz. A obecne pasmo 5 GHz jest podzielone na kilka części za pomocą różnych metod dostępu bezprzewodowego, których nie można używać jednolicie. Ponieważ zasoby widma wykorzystywane przez sieci komunikacji bezprzewodowej i systemy radarowe pokrywają się, FCC i ETSI wymagają, aby mechanizm dynamicznego wyboru częstotliwości (DFS) był używany w paśmie Sub-6 GHz, aby uniknąć zakłóceń systemu radarowego. A większość metod dostępu do dostępnego widma w paśmie niskich częstotliwości to Listen Before Talk (LBT). LBT spowoduje dużą liczbę okresów bezczynności w korzystaniu z widma, co skutkuje niskim wykorzystaniem widma, co jest głównym oporem wobec wizji sieci 5G o niskim opóźnieniu. Ostatnio FCC promuje dodatkowe widmo do nielicencjonowanego użytku w zakresie 5,925 GHz - 7,125 GHz. Jest to powszechnie określane jako pasmo 6 GHz, a jego regulacje są obecnie określone. Obecny trend rozszerzania 12 6G Wireless Communications i Mobile Networking Xie et al. Dostępność nielicencjonowanego dostępu, nawet w obszarze widma poniżej 10 GHz, radzi sobie z koniecznością radzenia sobie z załamaniem widma w związku z wykładniczym wzrostem aplikacji bezprzewodowych. Nielicencjonowany dostęp wyeliminował również przestarzały paradygmat licencjonowania, o którym wiadomo, że prowadzi do nieefektywnego wykorzystania widma.

mmWave

Wiadomo, że docelowa szybkość transmisji danych w komunikacji mobilnej 5G Sub-6 GHz to poziom Gbps, a docelowa szybkość transmisji 5G mmWave wynosi około 10 Gbps. Istnieją dwa kluczowe sposoby zwiększenia szybkości transmisji danych bezprzewodowych: jeden to poprawa wydajności widmowej, a drugi to wykorzystanie dużej szerokości pasma częstotliwości lub zasób widma

Komunikacja 6G mmWave

Zalety mmWave

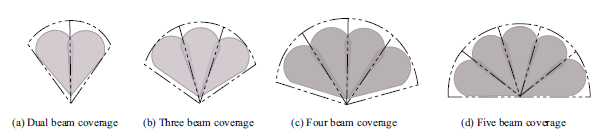

W rozwoju systemów komunikacji mobilnej w przeszłości w pełni zbadano komunikację mikrofalową o niskiej częstotliwości reprezentowaną przez pasma 2,4 GHz i 5 GHz. Jednakże, w wyniku ograniczonej fizycznej szerokości częstotliwości i zajmowania przez coraz większy ruch sieciowy, komunikacja mikrofalowa o niskiej częstotliwości stała się bardzo zatłoczona i nie może sprostać wymaganiom przepustowości nowej generacji systemów komunikacji mobilnej. W związku z tym komunikacja na falach milimetrowych (mmWave) stanie się jedną z głównych technologii wspierających nową generację systemów komunikacji bezprzewodowej ze względu na dużą przepustowość, małe opóźnienia, wysoką szybkość i przyjazną funkcję pozycjonowania. Pasmo mmWave jest zwykle definiowane jako fale elektromagnetyczne w domenie częstotliwości 30GHz-300GHz. Znajduje się w zachodzącym na siebie zakresie fal mikrofalowych i dalekiej podczerwieni, dzięki czemu ma cechy obu widm. Ponieważ jego długość fali wynosi 1ms-10ms, nazywana jest falą milimetrową. Od czasu rozwoju Internetu demokratyzacja informacji lepsza edukacja, handel elektroniczny sprzyjał wzrostowi gospodarczemu, a innowacje biznesowe zostały przyspieszone dzięki wspieraniu szerszej współpracy. A teraz wkraczamy w erę Internetu wszystkiego (IoE) integrującego miliardy, a nawet biliony połączeń. Wszystko zyska świadomość kontekstową, wzmocnioną przez możliwości przetwarzania i lepsze możliwości wykrywania. Dlatego Internet Wszechrzeczy stanie się scenariuszem aplikacji, który należy uwzględnić w nowej generacji systemów komunikacji mobilnej. Duża przepustowość i duża prędkość, jakie może zapewnić mmWave, umożliwiają firmom takim jak wideo w wysokiej rozdzielczości, rzeczywistość wirtualna, rzeczywistość rozszerzona, gęste usługi informacji miejskiej, sterowanie automatyzacją fabryk i telemedycyna. Można powiedzieć, że rozwój i wykorzystanie mmWave zapewnia szeroką przestrzeń dla aplikacji 5G w oparciu o usługi Sub-6. Ale istnieje ogromna wada polegająca na tym, że mmWave ma poważne tłumienie podczas propagacji w porównaniu z innymi pasmami częstotliwości. A ze względu na dużą dostępną przepustowość oryginalna rozdzielczość systemów komunikacyjnych mmWave jest mniejsza niż w przypadku tradycyjnych systemów komunikacyjnych o niskiej częstotliwości. Dlatego mmWave od dawna nie pojawił się na polu komunikacji mobilnej. Qualcomm przepisuje odpowiedni lek. Po pierwsze, wykorzystuje technologię wielowiązkową, aby sprostać wyzwaniom związanym z mobilnością i poprawić zasięg, niezawodność i działanie poza zasięgiem wzroku. Po drugie, wykorzystuje dywersyfikację ścieżki do radzenia sobie z problemami z blokowaniem i wykorzystuje dywersyfikację anteny końcowej do poprawy niezawodności. Na koniec przeprowadzono kilka testów OTA wewnątrz i na zewnątrz, aby zweryfikować mobilność. Dlatego realizowane jest zastosowanie mmWave w telefonach komórkowych.

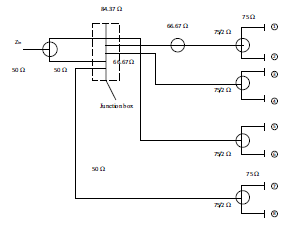

Nielicencjonowane pasma mmWave

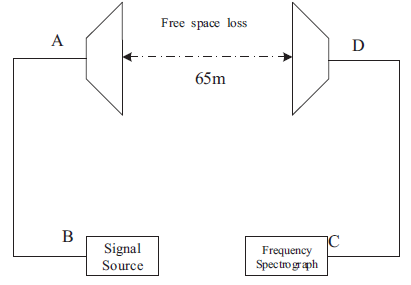

W paśmie częstotliwości 60GHz mmWave dla nielicencjonowanego dostępu dostępne jest pasmo około 7 GHz, które jest znacznie większe niż nielicencjonowane widmo słońca-6GHz. W tak szerokim dostępnym widmie, aby osiągnąć szczytową szybkość transmisji 100 Gbps wymaganą przez sieć 5G, wymagana jest co najmniej szybkość wykorzystania widma wynosząca 14 bitów/Hz na jednostkę czasu. Jednak istniejąca technologia modulacji/demodulacji danych i powiązane oryginalne urządzenia nie mogą sprostać tak ścisłemu wykorzystaniu widma i wierności symboli. W związku z tym, jedną z obecnych trudności badawczych w dziedzinie systemów komunikacji bezprzewodowej jest osiągnięcie szybkości transmisji 100 Gbps w paśmie wysokich częstotliwości powyżej 100 GHz. Na przykład FCC zdecydowała się otworzyć cztery pasma częstotliwości mmWave powyżej 95 GHz w Stanach Zjednoczonych w 2019 r. Jak pokazano w tabeli 1, w celu uzyskania dostępu bez licencji zapewniona jest łączna przepustowość około 21 GHz.

Opcje widma dla 6G

Pasmo częstotliwości 26 GHz-100 MHz to duża szansa dla sieci komórkowych. Jednak jest to wcześniej niepopularna cecha mmWave, która sprawia, że jest ona bardzo odpowiednia dla 5G. Opiera się na wykorzystaniu mikroinfrastruktury, takiej jak małe jednostki rozmieszczone w gęsto zabudowanych lokalizacjach miejskich. 5G musi wykorzystywać szersze spektrum niż poprzednie generacje systemów mobilnych. Zgodnie z tym trendem oczekuje się, że w sieciach komunikacji bezprzewodowej 6G będzie wykorzystywane wyższe pasmo częstotliwości. Dlatego wstępnie ustawiliśmy system 6G do wdrożenia w paśmie subterahercowym 114 GHz-300 GHz. Zgodnie z właściwościami fizycznymi ultrawysokiej częstotliwości widmo subterahercowe może uzupełniać transmisję ultrawąskiej wiązki, poprawiając w ten sposób wydajność widma i zapewniając precyzyjne pozycjonowanie. Dzięki temu pasmo subterahercowe może dobrze działać w scenariuszach, takich jak przyszłe sieci dosyłowe i komunikacja na krótkich dystansach w czasie rzeczywistym. Z drugiej strony przewiduje się, że liczba urządzeń mobilnych na całym świecie wyniesie ponad 125 miliardów w latach 30. XX wieku, w tym telefony komórkowe, tablety, urządzenia do noszenia, zintegrowane zestawy słuchawkowe, wszczepiane czujniki i inni użytkownicy maszyn. System Internetu Rzeczy (IoT), łączący miliony ludzi i miliardy urządzeń, będzie jednym z podstawowych scenariuszy aplikacji dla mmWave B5G i 6G.

Teraherc (THz)

Jako medium propagacji bezprzewodowych systemów komunikacji mobilnej, zasoby widma będą coraz bardziej ograniczone w miarę rozwoju rodzajów i wymagań usług komunikacyjnych. Na początku prac badawczo-rozwojowych nad 5G pojawiły się sugestie, aby szukać skalowalnych zasobów widma w kierunku teraherca i światła widzialnego. Teraherc to nowe źródło promieniowania o wielu wyjątkowych zaletach. Ma szerokie zastosowanie w wielu dziedzinach, takich jak materiały półprzewodnikowe, technologia tomografii, badania genetyczne bez etykiet, szerokopasmowa komunikacja i orientacja mikrofalowa. Badanie źródeł promieniowania w tym paśmie częstotliwości nie tylko przyczyni się do znacznego rozwoju badań teoretycznych, ale także postawi poważne wyzwania dla elektroniki półprzewodnikowej i technologii obwodów. Rozwój i wykorzystanie widma terahercowego w dziedzinach takich jak komunikacja jest wysoko cenione przez Europę, Stany Zjednoczone, Japonię oraz inne kraje i regiony. Otrzymali także silne wsparcie ze strony ITU.

Komunikacja terahercowa 6G

Widmo terahercowe

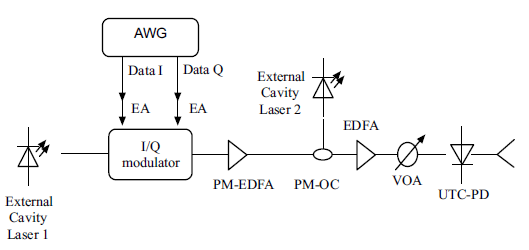

Wraz z rozwojem nauki i technologii gwałtownie rośnie ilość komunikacji i połączeń usług bezprzewodowych. Zwłaszcza od ery 5G szybki rozwój technologii komunikacji bezprzewodowej w kosmosie i na niebie sprawił, że dwuwymiarowa analiza wydajności kanałów bezprzewodowych nie ma już zastosowania. W sieci 6G musimy wykonać trójwymiarowe modelowanie kanału bezprzewodowego i obliczyć odpowiednie parametry wydajności w jednostkowej przestrzeni sześciennej, co wymaga szerszego pasma widma RF. Widmo częstotliwości jest wielkością fizyczną istniejącą w przyrodzie, której nie można zwiększać ani zmniejszać, dlatego jest niezwykle cenne. Fale terahercowe odnoszą się do fal elektromagnetycznych o częstotliwościach w zakresie 0,1 THz-10 THz, pomiędzy falami milimetrowymi a światłem podczerwonym. Jest to strefa przejściowa od makroskopowej teorii klasycznej do mikroskopowej teorii kwantowej, a także strefa przejściowa od elektroniki do fotoniki, zwana przerwą terahercową widma elektromagnetycznego. Komercyjne zastosowanie technologii terahercowej jeszcze kilka lat temu nie wydawało się wystarczająco jasne. Jednak terahercowe przyrządy pomiarowe wykazały ogromny potencjał rynkowy w 2018 r. Zastosowania w zakresie bezpieczeństwa cywilnego, badania nieniszczące i przemysłowa kontrola jakości mogą czerpać korzyści z zastosowania systemów terahercowych. Tradycyjnie pasmo częstotliwości 26,5-300 GHz jest definiowane jako pasmo mmWave, a 300-10000 GHz jako pasmo THz. Jednak w ostatnich latach powszechnie przyjęto definicję 100-10000 GHz (lub 0,1-10 THz) jako pasma THz. Wraz z krytycznym rozwojem komunikacji bezprzewodowej, pasma częstotliwości THz były postrzegane jako obiecujący kandydat do dostarczenia wystarczających zasobów widma dla niedalekiej przyszłości 6G. W szczególności pasmo terahercowe może być do czterech rzędów wielkości wyższe niż istniejąca komunikacja mikrofalowa, co oznacza, że może przenosić większą ilość informacji. Ponadto teraherc łączy zalety komunikacji mikrofalowej i komunikacji optycznej, z wieloma cechami, takimi jak wysoka szybkość transmisji, duża pojemność, silna kierunkowość, wysokie bezpieczeństwo i dobra penetracja [26]. Dzięki tym oczywistym zaletom przeprowadzono szeroko zakrojone badania nad komunikacją THz na całym świecie.

Zalety Teraherc

Komunikacja terahercowa ma wiele zalet w porównaniu z mikrofalową i bezprzewodową komunikacją optyczną dzięki swoim unikalnym właściwościom. Wraz z rozwojem technologii terahercowej stopniowo ujawniają się jej wyjątkowe zalety i ogromne perspektywy zastosowań w wielu ważnych dziedzinach radarów komunikacyjnych, komunikacji w dalekim kosmosie, szybkiej komunikacji bezprzewodowej krótkiego zasięgu i komunikacji bezprzewodowej w zakresie bezpieczeństwa.

1. Fala terahercowa jest bardziej odpowiednia do szybkiej komunikacji bezprzewodowej krótkiego zasięgu, ponieważ podczas propagacji łatwo wpływa na nią wilgoć z powietrza, powodując poważne tłumienie sygnału.

2. Fale terahercowe mają wąskie wiązki, dobrą kierunkowość i silne właściwości przeciwzakłóceniowe. Dlatego bezpieczna komunikacja w promieniu 2-5 km może być realizowana za pomocą fal terahercowych.

3. Właściwości fizyczne teraherców o wysokiej częstotliwości i szerokości pasma mogą sprostać stale rosnącemu zapotrzebowaniu na przepustowość komunikacji bezprzewodowej. Widmo terahercowe ma użyteczną szerokość pasma dziesiątek GHz w zakresie 108-1013 GHz, co może zapewnić szybkość przekraczającą Tbit na sekundę.

4. Jeśli chodzi o komunikację kosmiczną, w pobliżu długości fali 350, 450, 620, 735 i 870 ?m fal terahercowych, pokazanych na rys. (6), znajdują się stosunkowo przezroczyste okna atmosferyczne, które mogą osiągnąć bezstratną transmisję. Bardzo mała moc może zakończyć komunikację na duże odległości. Co więcej, terminal odbiorczy jest łatwy do wyrównania, ponieważ wiązka fal terahercowych jest szersza w porównaniu z bezprzewodową komunikacją optyczną. Szum kwantowy jest niższy, a antena może być zminiaturyzowana i płaska. Dlatego fale terahercowe mogą być szeroko stosowane w komunikacji kosmicznej i są szczególnie odpowiednie do komunikacji szerokopasmowej, takiej jak komunikacja satelitarna i komunikacja satelita-ziemia.

5. Pasmo terahercowe jest również odpowiednie dla Massive MIMO z większą liczbą anten (ten sam rozmiar lub nawet mniejsza objętość anteny w porównaniu do fal milimetrowych) ze względu na krótką długość fali. Wstępne badania pokazują, że wzmocnienie formowania wiązki i multipleksacji przestrzennej zapewniane przez Massive MIMO może skutecznie przezwyciężyć zanikanie deszczu i zanikanie atmosferyczne propagacji terahercowej, co może spełnić wymagania dotyczące zasięgu gęstych obszarów miejskich, takich jak komórka o promieniu 200 m.

6. Ze względu na niską energię fotonów fal terahercowych, w porównaniu z bezprzewodową komunikacją optyczną, fale terahercowe jako nośniki informacji mają zaletę wysokiej wydajności energetycznej.

7. Teraherc ma bardzo krótką długość fali, ma wysoki stosunek sygnału do szumu w widmie czasowym, może przenikać przez ściany z niewielkim tłumieniem i jest idealną technologią do obrazowania przez ściany w złożonych środowiskach.

Wyzwania w pasmach terahercowych

Pasmo częstotliwości terahercowych ma niezastąpione korzyści w komunikacji mobilnej. Jednak stoi też przed wieloma wyzwaniami.

1. Odległość komunikacyjna: Ze względu na krótką długość fali i wysoką częstotliwość terahercową ma większe zanikanie wolnej przestrzeni niż pasma o niskiej częstotliwości. Ponadto istniejące mechanizmy komunikacji mogą nie być odpowiednie dla wysoce kierunkowych charakterystyk propagacji terahercowych.

2. Blaknięcie na dużą skalę: cienie mają znaczący wpływ na transmisję sygnałów radiowych terahercowych o ultrawysokich częstotliwościach. Na przykład po przejściu sygnału terahercowego przez ludzkie ciało jego sygnał jest tłumiony o co najmniej 20 dB, a po przejściu przez ceglaną ścianę jego tłumienie może sięgać nawet 80 dB. Jednak ponieważ zanikanie wilgotności/deszczu dotyczy głównie sygnałów radiowych o częstotliwościach poniżej 100 GHz, pasmo terahercowe powyżej 100 GHz ma mniejszy wpływ.

3. Szybkie przełączanie i odłączanie kanałów: Czas koherencji kanału ma liniową zależność od częstotliwości nośnej dla danej prędkości ruchu. Dlatego też, ponieważ czas koherencji jest bardzo mały, teraherc ma większe przesunięcie Dopplera, a większe zanikanie cienia prowadzi do znacznej utraty ścieżki, co ostatecznie powoduje, że komunikacja terahercowa ma problemy z częstym przełączaniem pasm częstotliwości i poważnymi fluktuacjami. Ponadto technologia terahercowa jest wykorzystywana głównie do pokrywania komunikacji wysokokierunkowej na małym obszarze. Oznacza to, że zanikanie ścieżki, wiązki obsługujące i relacje asocjacji komórek będą się szybko zmieniać. Aby rozwiązać problem przerw w połączeniu spowodowanych częstym przełączaniem częstotliwości, musimy zaprojektować nowy mechanizm szybkiej komunikacji adaptacyjnej z perspektywy systemowej.

4. Zużycie energii: Główną trudnością w stosowaniu anten o bardzo dużej skali jest zużycie energii przez szerokopasmową konwersję analogowo-cyfrową systemu terahercowego. Zużycie energii generalnie ma liniową zależność od częstotliwości próbkowania i wykładniczą zależność od liczby próbek na jednostkę. Szerokie pasmo częstotliwości terahercowych i duża liczba anten wymagają kwantyfikacji o wysokiej rozdzielczości. Dlatego też dużym wyzwaniem będzie wdrożenie urządzeń o niskim poborze mocy i niskich kosztach.

Powiązana technologia komunikacji terahercowej

Poniżej przedstawiono kilka kluczowych treści badawczych związanych z rozwojem technologii komunikacji terahercowej w przyszłości.

1. Technologia półprzewodnikowa, w tym RF, analogowe pasmo podstawowe i logika cyfrowa itp.;

2. Zbadaj szybkie przetwarzanie sygnału pasma podstawowego o niskiej mocy, odpowiednią konstrukcję układu scalonego o niskiej złożoności i szybką platformę komunikacji pasma podstawowego opartą na częstotliwościach terahercowych;

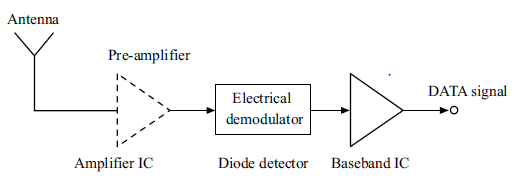

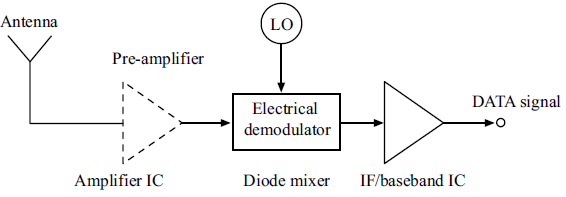

3. Technologia modulacji/demodulacji terahercowej, w tym modulacja bezpośrednia, modulacja mieszania, modulacja fotoelektryczna itp.;

4. Kodowanie przebiegu i kanału;

5. Mechanizm synchronizacji, na przykład technologie śledzenia i synchronizacji setek rzędów wielkości elementów antenowych w scenariuszach gęstego dostępu;

6. Pomiar kanałów i modelowanie przestrzeni terahercowej i komunikacji naziemnej.

Badania nad wyżej wymienionymi kilkoma aspektami zagadnień technicznych należy rozważyć kompleksowo, aby znaleźć równowagę między wydajnością, złożonością i zużyciem energii w komunikacji terahercowej. Ponadto ITU zdecydowało przydzielić nowej generacji łączności ruchomej 0,12 THz i 0,2 THz w zakresie nadzoru widma. Jednak zasady regulacyjne dla pasma przekraczającego 0,3 THz nie zostały jeszcze ujednolicone globalnie. Poziom ITU i spotkanie WRC muszą współpracować i aktywnie promować osiągnięcie konsensusu.

STRESZCZENIE

W tej części przedstawiono głównie stan badań sieci komórkowych 6G z naciskiem na skład widmowy systemu łączności nowej generacji. Ponieważ sieci 5G z trudem mogą spełnić wszystkie wymagania przyszłego rozwijającego się społeczeństwa w 2030 r. i później, badania nad 6G stały się nieuniknione i wzbudziły zainteresowanie na całym świecie. Aby osiągnąć znacznie szybszą transmisję danych niż 5G, należy wykorzystać wyższe widma częstotliwości niż w poprzedniej generacji. Szczególnie szczegółowo podkreśliliśmy zalety widm mmWave i Terahertz. Przedstawiamy również międzynarodowe organizacje normalizacji 6G oraz postępy w technologii 6G w różnych krajach.

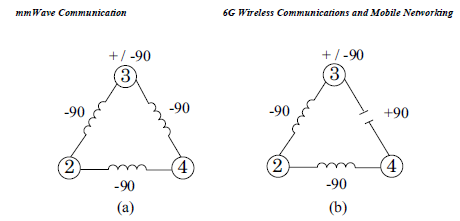

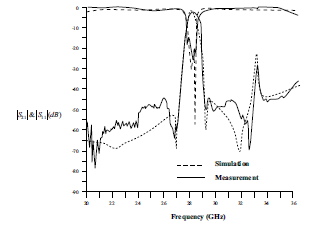

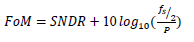

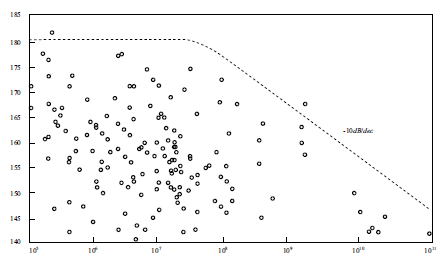

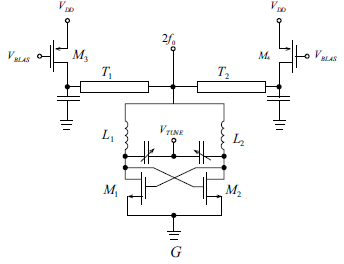

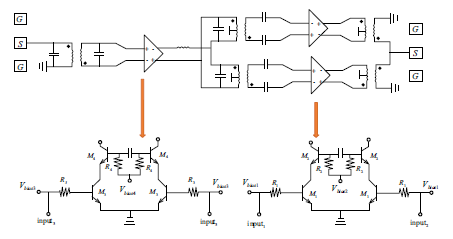

Technologia komunikacji fal milimetrowych

Fala milimetrowa odgrywa nieodzowną rolę w nowej generacji komunikacji mobilnej ze względu na obfitość nieodkrytych zasobów, które można wykorzystać do spełnienia wymagań większej przepustowości i ultrawysokiej szybkości transmisji danych. Ta część najpierw przedstawia rozwój, charakterystykę i zastosowania fal milimetrowych. Następnie szczegółowo opisano zastosowanie fali milimetrowej w systemach komunikacji mobilnej oraz wymieniono model wspólnego kanału. Po drugie, wprowadzono wielkoskalowy system MIMO, technologię wstępnego kodowania i trzy rodzaje struktur formujących wiązki. Na koniec, w połączeniu z obecnym rozwojem komunikacji mobilnej, podsumowano wymagania stawiane urządzeniom wykorzystującym fale milimetrowe dla nowej generacji systemów komunikacji mobilnej oraz wymieniono niektóre typowe urządzenia wykorzystujące fale milimetrowe.

WPROWADZANIE

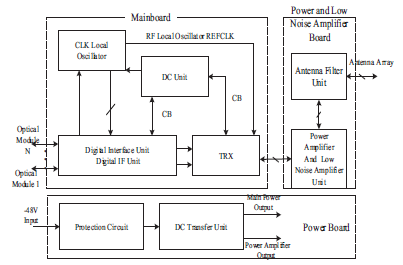

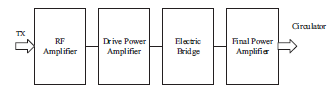

Narodziny każdej generacji technologii komunikacji mobilnej zapewniły nam wielką wygodę w życiu. Pojawienie się technologii telefonii komórkowej drugiej generacji (2G) zapewniło nam wygodne połączenia głosowe. W erze 3G możemy wykorzystać mobilny Internet do realizacji podstawowych funkcji sieciowych. Od dziesięciu lat szybki internet mobilny w dobie 4G wprowadził wideorozmowy i mobilne oglądanie filmów do naszego życia. 5G to era Internetu wszystkiego, który czerpie korzyści z większej przepustowości kanału, większych prędkości sieci i mniejszych opóźnień w porównaniu do 4G. W oparciu o te cechy telemedycyna, inteligentny dom, sztuczna inteligencja (AI), Internet rzeczy (IoT) itd. będą rozwijane i lepiej stosowane. Zasoby widma 5G są podzielone na FR1 i FR2 według częstotliwości. FR1 to część o niskiej częstotliwości 450~6000 MHz, która jest również nazywana Sub 6 GHz. FR2 jest częścią pasma częstotliwości fal milimetrowych (mmWave) (24,25~52,6 GHz). Specyficzny podział widma 5G w Chinach został ukończony w 2018 roku. Ponieważ fala elektromagnetyczna o niskiej częstotliwości ma dużą długość fali, ma małą stratę ścieżki i duży obszar zasięgu. Tymczasem odpowiednia technologia komunikacyjna pasma niskiej częstotliwości jest dojrzała, a koszt aplikacji jest niski, co może szybko zrealizować wdrożenie 5G. Dlatego Sub 6 GHz jest głównym pasmem częstotliwości dla rozwoju komunikacji mobilnej w Chinach na tym etapie. Jednak pasmo częstotliwości mmWave jest nadal ważnym pasmem częstotliwości dla przyszłego rozwoju 5G w Chinach. W porównaniu z Sub 6 GHz, przepustowość. Pasmo częstotliwości mmWave to GHz, co może zapewnić wyższą szybkość transmisji i pomieścić więcej informacji o danych. Często znajduje się na gęsto zaludnionym obszarze i ma wysoką wartość użytkową w dziedzinie przemysłu. W ostatnich latach, wraz z rozwojem komunikacji mobilnej, badania nad komunikacją mmWave stały się głównym międzynarodowym zainteresowaniem. Komunikacja mmWave i masowe MIMO są uważane za dwie kluczowe technologie 5G. Ze względu na dużą szerokość pasma pasma częstotliwości mmWave można było spełnić wysokie wymagania dotyczące szybkości transmisji systemów komunikacji mobilnej nowej generacji. Ponieważ fala milimetrowa ma krótką długość fali, wielkość dużych szyków antenowych można zminiaturyzować. Tymczasem wykorzystanie kierunkowego wzmocnienia kształtowania wiązki zapewnianego przez ogromny system MIMO może skutecznie skompensować utratę ścieżki sygnałów mmWave w kanale bezprzewodowym. Obecne badania nad nową generacją komunikacji mobilnej, od planowania i autoryzacji zasobów widmowych o określonych potrzebach, po badania i rozwój różnych urządzeń mmWave i budowę nowej generacji systemów komunikacji mobilnej, poczyniły ogromne postępy. Ogólnie rzecz biorąc, wyzwania stojące przed komunikacją na falach milimetrowych są uważane głównie za urządzenia o wysokiej częstotliwości. Powiązane komponenty rdzenia wysokiej częstotliwości obejmują głównie wzmacniacze mocy, wzmacniacze niskoszumowe, obwody pętli fazowej, filtry, szybkie i precyzyjne przetworniki cyfrowo-analogowe i analogowo-cyfrowe, anteny macierzowe itp.

CHARAKTERYSTYKA I ZASTOSOWANIE FALI MILIMETROWEJ

Wraz z przyspieszeniem informatyzacji społeczeństwa ludzkiego rozszerza się zakres zastosowań widma elektromagnetycznego. W latach 70. Światowa Konferencja Radiowa zorganizowana przez Międzynarodowy Związek Telekomunikacyjny (ITU) podzieliła i przydzieliła pasmo częstotliwości 30-70 GHz wykorzystywane przez usługi komunikacyjne. W ostatnich latach, w związku z ciągłym wzrostem zapotrzebowania na szerokopasmową i wielkoprzepustową transmisję informacji, komunikację osobistą oraz wojskową łączność poufną/antyzakłóceniową, pola mmWave, a nawet fale submilimetrowe stały się niezwykle aktywnym polem badań, rozwoju, oraz wykorzystanie międzynarodowych zasobów widma elektromagnetycznego, które zawierają obfite zasoby informacyjne. Aby zwiększyć przepustowość komunikacji i uniknąć przeciążenia kanałów i wzajemnych zakłóceń, częstotliwość komunikacji musi zostać przekształcona w wyższe pasmo częstotliwości. Dlatego rozwój zasobów widma elektromagnetycznego w pasmach mmWave i terahercowych jest ostatnio kluczowymi dziedzinami badań w elektronice, a zasoby widma w paśmie mmWave mają znaczące wartości aplikacyjne. Generalnie fale elektromagnetyczne o zakresie częstotliwości 30~300GHz nazywane są falami mmWave i można je podzielić na kilka pasm częstotliwości. Kody pasm częstotliwości i zakresy częstotliwości są pokazane w tabeli

Charakterystyka fali milimetrowej

Długość fali milimetrowej mieści się w zakresie nakładania się fal mikrofalowych i podczerwonych, co ma cechy obu tych fal. Teoria i technologia fali milimetrowej to rozszerzenie mikrofal do wysokiej częstotliwości i rozwinięcie fal świetlnych do niskiej częstotliwości.

Użyteczna przepustowość częstotliwości i duża pojemność informacji

Pasmo częstotliwości mmWave mieści się w zakresie od 30 do 300 GHz, przy szerokości pasma do 270 GHz, co stanowi ponad 10-krotność pełnego pasma od prądu stałego do mikrofal. Biorąc pod uwagę absorpcję atmosfery, dla mmWave występują głównie cztery okna propagujące. Łączna przepustowość tych czterech okien może osiągnąć 135 GHz, co jest pięciokrotnością sumy przepustowości każdego pasma poniżej mikrofal. Dlatego głównymi zaletami komunikacji mmWave są przepustowość i duża pojemność informacyjna, które można wykorzystać do komunikacji wielokanałowej i transmisji obrazu telewizyjnego. Ponadto wysoka szybkość transmisji sprzyja realizacji komunikacji z małym prawdopodobieństwem przechwycenia, takiej jak komunikacja z widmem rozproszonym i komunikacja z przeskokami częstotliwości. Częstotliwości o wysokiej stratności (takie jak 60 GHz, 120 GHz i 180 GHz) mogą być również wykorzystywane do poufnej komunikacji wojskowej i komunikacji satelitarnej.

Krótka długość fali w paśmie fal milimetrowych

W porównaniu z falą centymetrową fala milimetrowa ma krótszą długość fali. Dlatego jego quasi-optyczne właściwości mogą być wykorzystane do uzyskania wyższej rozdzielczości kątowej w przypadku stosunkowo małej apertury anteny. Co więcej, można osiągnąć wyższą dokładność pozycjonowania w przestrzeni w celu prowadzenia nawigacji, pozycjonowania i śledzenia celu. Stosunek sygnału docelowego do zagłuszania pasywnego jest wyższy i ma lepszą stabilność przeciwzakłóceniową do zagłuszania aktywnego.

Znaczący wpływ atmosfery na transmisję fal milimetrowych Kiedy fale elektromagnetyczne rozchodzą się w atmosferze ziemskiej, atmosfera pochłania i emituje promienie o różnych długościach fal. Chociaż efekt ten jest niewielki przy niskich częstotliwościach, absorpcja atmosfery jest widoczna dla pasma częstotliwości fal mm i zmienia się wraz z częstotliwością. Tłumienie atmosferyczne jest silne w niektórych określonych pasmach częstotliwości. Kiedy fale elektromagnetyczne o określonej częstotliwości padają na cząsteczki atmosferyczne, energia jest przenoszona w wyniku rezonansu. Jeśli cząsteczki powrócą do swojego pierwotnego stanu, energia jest uwalniana z tą samą częstotliwością. Uwolniona energia jest wypromieniowywana losowo, a wynikiem jest pochłanianie i tłumienie fal elektromagnetycznych oraz wkładu szumu. Różne gazy atmosferyczne mają zjawisko rezonansu w paśmie częstotliwości mmWave, ale tylko tlen i para wodna mają oczywiste właściwości absorpcji. Tlen ma magnetyczny moment dipolowy. Istnieje ponad 40 linii rezonansowych wokół 60 GHz i jedna linia rezonansowa na 118,75 GHz. Para wodna ma elektryczny moment dipolowy, którego widmo rezonansowe wynosi około 22 GHz i 183 GHz w paśmie mmWave. Zakres częstotliwości linii przesyłowej i tłumienie atmosferyczne przedstawiono w tabeli

.

W porównaniu z falami świetlnymi, fala milimetrowa rozchodzi się z oknami atmosferycznymi (gdy fala milimetrowa i fala submilimetrowa rozchodzą się w atmosferze, pewne tłumienie spowodowane absorpcją rezonansową cząsteczek gazu jest wartością minimalną). Wpływ źródła promieniowania cieplnego jest niewielki. Prawidłowy dobór częstotliwości ma kluczowe znaczenie przy projektowaniu systemów mmWave.

Zastosowanie fali milimetrowej

W porównaniu z mikrofalami, mmWave odpowiada krótszym długościom fal i w pewnym stopniu pokrywa się z końcem niskiej częstotliwości fal terahercowych. Ze względu na różne charakterystyki widma i propagacji, zakres zastosowań fal mmWave jest szeroki.

System komunikacji fal milimetrowych

Wraz z ciągłym postępem globalnej informatyzacji wymagania ludzi dotyczące szybkości transmisji, przepustowości transmisji i jakości transmisji systemów komunikacyjnych stale rosną, co prowadzi do narodzin technologii bezprzewodowego dostępu szerokopasmowego na falach milimetrowych. Ponadto od lat 90. system komunikacji satelitarnej wystrzelił na orbity synchroniczne prawie 200 satelitów komunikacyjnych. Pasmo częstotliwości komunikacji zajmuje głównie pasmo C, a następnie pasmo Ku, powodując problem przeciążenia widma komunikacji satelitarnej. Wprowadzenie mmWave może zwiększyć przepustowość i szybkość transmisji komunikacji satelitarnej. Ponadto mmWave ma silne właściwości przeciwzakłóceniowe i ukrywanie, dzięki czemu komunikacja satelitarna jest bezpieczniejsza i bardziej niezawodna.

Broń o milimetrowej fali

W porównaniu z bronią naprowadzaną na podczerwień lub naprowadzaną laserowo, broń naprowadzana na fale milimetrowe ma większą zdolność do penetracji dymu, pyłu lub chmur, a także ma niższe tłumienie i utratę atmosfery w oknie transmisyjnym. Dzięki temu mogą być używane w bardzo trudnych warunkach, takich jak niesprzyjająca pogoda lub złożone pole bitwy, i działają normalnie, aby osiągnąć efekt precyzyjnych uderzeń. Innym zastosowaniem broni jest bezpośrednie użycie mmWave do generowania impulsów mikrofalowych o dużej mocy, aby trwale uszkodzić sprzęt elektroniczny. W przypadku ludzkiego ciała, ponieważ głębokość skóry mmWave wynosi tylko 0,4 mm, ten impulsowy sygnał mikrofalowy o dużej mocy nie zagraża życiu, ale spowoduje nieznośne uczucie pieczenia na naskórku i utratę skuteczności bojowej.

Technologia obrazowania fal milimetrowych

Tradycyjna technologia obrazowania rentgenowskiego jest używana w większości przypadków kontroli bezpieczeństwa na lotniskach i dworcach, ale promieniowanie generowane przez ten sprzęt jest szkodliwe dla ludzkiego ciała. Dlatego nie zaleca się wielokrotnych kontroli bezpieczeństwa w krótkim czasie, w przeciwnym razie może to spowodować nieodwracalne uszkodzenie ciała ludzkiego. Fala mmWave może penetrować popularne materiały ekranujące, takie jak odzież, plastik lub papier, i ma wysoką rozdzielczość. Może dokładnie identyfikować przewożone towary niebezpieczne bez generowania promieniowania jonizującego. Dlatego w porównaniu z tradycyjną technologią kontroli bezpieczeństwa rentgenowskiego jest bardziej odpowiedni dla pola kontroli bezpieczeństwa ludzkiego ciała.

Radar fal milimetrowych

Technologia radarowa jest również ważną częścią narodowej siły obronnej. Szybki rozwój wysokowydajnych źródeł mmWave znacznie poprawił wydajność radaru. Na przykład może rozróżniać mniejsze cele i rozróżniać wiele celów jednocześnie, a także może dostosować się do złożonego środowiska pogodowego itp. Jednocześnie radar mmWave może być mniejszy i lżejszy, co odpowiada potrzebom rozwoju wojskowy sprzęt elektroniczny.

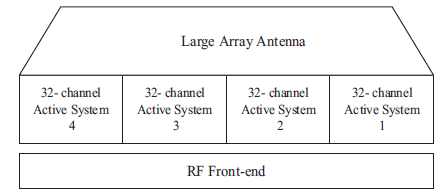

TECHNOLOGIA FALI MILIMETROWYCH W KOMUNIKACJI MOBILNEJ

Jako poddział mikrofal, mmWave wykazuje wiele wspólnych cech w transmisji komunikacyjnej. mmWave jest szeroko stosowany w różnych dziedzinach ze względu na dobre właściwości przeciwzakłóceniowe, dobrą charakterystykę bezpieczeństwa, szerokie pasmo, niskie zużycie energii i tak dalej. Technologia komunikacji mmWave obejmuje dwa aspekty: dalszy rozwój fali świetlnej do niskiej częstotliwości, rozszerzenie mikrofal do wysokiej częstotliwości. Obecnie zasoby pasma częstotliwości wykorzystywanych na świecie są bardzo ograniczone, a widmo wykorzystywanego bezprzewodowego systemu telekomunikacyjnego jest mniejsze niż 6 GHz. Jednak zasoby widma w zakresie 3~60 GHz są wystarczające i nie zostały skutecznie opracowane i wykorzystane. Z tego powodu komunikacja mobilna nowej generacji przyjmuje pasmo 9,9 ˜ 86 GHz jako kluczowy przedział i umożliwia bardziej dogłębną eksplorację szerokiego zasięgu Internetu w oparciu o technologię LTE (Long Term Evolution). To pasmo służy do tworzenia sieci supergęstej, a warstwa LTE i warstwa UDN (Ultra-Dense Network) zostaną pokryte podwójnie. Wraz ze wzrostem liczby anten stacji bazowych, duża liczba anten może być rozmieszczona na niewystarczającej przestrzeni, a długość fali komunikacji nie jest zbyt długa. Wraz ze wzrostem liczby urządzeń bezprzewodowych i niedoborem zasobów widma, ograniczona przepustowość może być dzielona tylko w wąskim spektrum, co znacznie wpływa na wrażenia użytkownika. Komunikacja 5G wykorzystuje technologię mmWave (26,5~300 GHz), która zwiększa szybkość poprzez zwiększenie przepustowości. Dostępna szerokość pasma dla 28 GHz wynosi około 1 GHz, natomiast dostępna szerokość pasma dla 60 GHz to 2 GHz. Fala mmWave ma wyjątkowe zalety w zakresie poprawy przepustowości i jakości sygnału oraz pokrycia. Obecnie, dzięki technologii wielu wejść i wyjść na dużą skalę w paśmie mmWave, Bell Laboratories w Chinach osiągnęło cel zwiększenia wydajności i wydajności komunikacji. Korzystając z prototypów o szczytowych prędkościach przesyłu przekraczających 50 Gb/s, laboratorium zwiększyło prędkość widma do 100 b/s na 28 GHz w paśmie mmWave 28 GHz, umożliwiając użytkownikom szybsze pobieranie za pomocą Internetu i dostarczanie nawet 100 megabajtów informacji w bardzo krótki okres czasu. Podsumowując, komunikacja mmWave zajmuje ważne pole zastosowań z własnymi zaletami i nie można jej zastąpić w krótkim okresie. W oparciu o charakterystykę mmWave, bardzo szybka komunikacja nowej generacji komunikacji mobilnej może być obsługiwana przez technologię mmWave. Zastosowanie technologii anten na dużą skalę do pasma mmWave. Komunikacja w celu osiągnięcia nowej generacji systemu komunikacji mobilnej jest wizją ogólnie akceptowaną przez branżę, która może skutecznie wspierać wymagania dotyczące przepustowości i wydajności widma systemu komunikacji mobilnej nowej generacji.

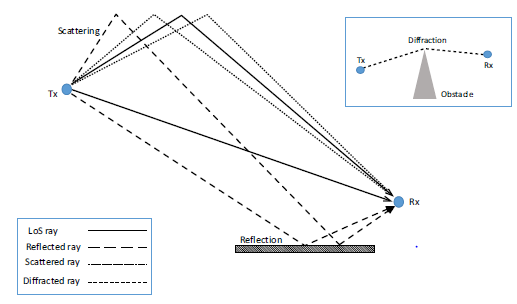

Model propagacji fali milimetrowej i model kanału

Jako medium transmisyjne w procesie komunikacji bezprzewodowej charakterystyka propagacji fali elektromagnetycznej w przestrzeni jest podstawą konfiguracji technologii transmisji, konstrukcji struktury anteny i planu sieci bezprzewodowej w systemie komunikacji bezprzewodowej. W przypadku pasma mmWave, ponieważ wielkość celu i długość fali w środowisku propagacji są porównywalne, propagacja w przestrzeni różni się od prawa propagacji niskich częstotliwości i jest ściśle związana ze środowiskiem propagacji. Fala mm jest silnie tłumiona w propagacji atmosferycznej, a odległość propagacji jest poważnie zduszony. Ponadto tłumienie fali elektromagnetycznej spowodowane absorpcją cząsteczek tlenu, cząsteczek pary wodnej i czynników opadowych jest również ściśle związane z częstotliwością. Fale elektromagnetyczne będą wykazywać różne mechanizmy propagacji, takie jak odbicie, dyfrakcja, rozpraszanie czy transmisja. Modele propagacji mmWave dzielą się głównie na dwie kategorie: model propagacji w dużej skali i model propagacji w małej skali. Celem wielkoskalowego modelu propagacji jest opisanie zmian mocy odbieranego sygnału wraz z odległością nadajnika-odbiornika na dużej odległości między nadajnikiem a odbiornikiem.

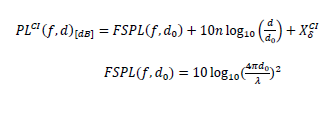

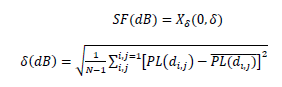

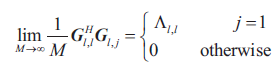

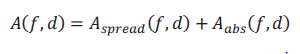

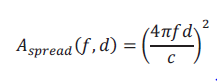

Model propagacji strat na dużą skalę

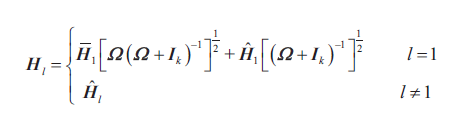

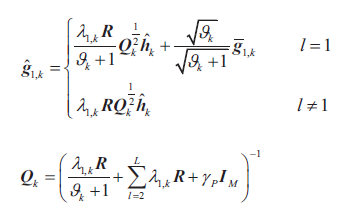

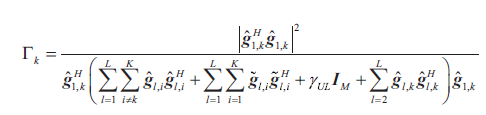

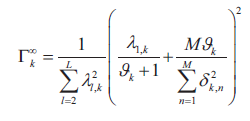

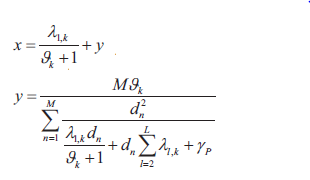

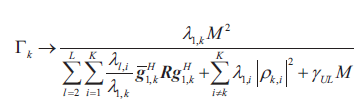

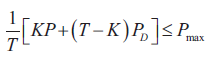

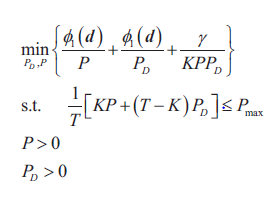

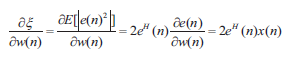

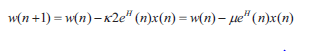

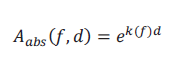

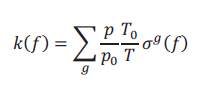

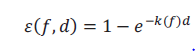

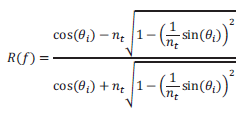

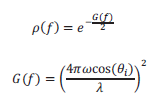

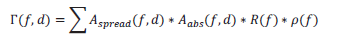

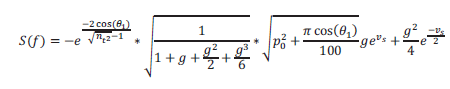

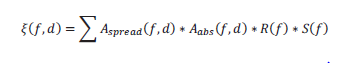

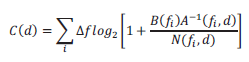

Wielkoskalowy model propagacji strat jest opisem charakterystyki zmiany siły sygnału fal elektromagnetycznych przesyłanych na duże odległości w kanale bezprzewodowym. W prostym środowisku kanału bezprzewodowego, wielkoskalowa charakterystyka strat opisuje proporcjonalny związek między siłą sygnału odbiornika a odległością. W przypadku kilku znanych modeli strat na dużą skalę, różne środowiska kanałów bezprzewodowych mają różne modele strat ścieżki. Utrata ścieżki odzwierciedla redukcję energii fali elektromagnetycznej po przejściu przez kanał bezprzewodowy. Generalnie wyraża się w wielkości redukcji mocy i odzwierciedla zmianę w odbieranej mocy odbiornika w efektywnym zasięgu transmisji na duże odległości. W ogólnym środowisku kanałowym, gdy przesyłana moc jest stała, utrata ścieżki jest proporcjonalna do odległości transmisji. Wraz ze wzrostem odległości propagacji siła sygnału stale się zmniejsza. Dlatego zmienna określona przez trend malejący nazywana jest wskaźnikiem utraty ścieżki. Im większy wskaźnik strat, tym szybciej siła sygnału maleje wraz ze wzrostem odległości. Najniższa wartość w systemie komunikacyjnym nie jest niższa niż próg odbioru odbiornika. Wskaźnik tłumienia ścieżki jest ściśle powiązany z częstotliwością fal elektromagnetycznych, właściwościami anteny i środowiskiem kanału. Istnieją różne wielkoskalowe modele utraty ścieżki (deterministyczne, empiryczne i losowe), a wszystkie z nich zapewniają rzeczywiste modele utraty ścieżki dla kanałów bezprzewodowych w oparciu o zmierzone parametry. Model podzielony jest na jednoczęstotliwościowe i wieloczęstotliwościowe modele utraty ścieżki, w tym następujące typowe wielkoskalowe modele utraty ścieżki. Najczęściej stosowanymi jednoczęstotliwościowymi modelami utraty ścieżki na dużą skalę są CI (Model utraty ścieżki odległości odniesienia w wolnej przestrzeni Close-In) i FI (Model utraty ścieżki Floating-Intercept). Wyrażenie modelu CI jest następujące:

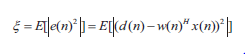

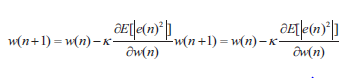

gdzie  jest zmienną losową o średniej zerowej Gaussa opartą na odchyleniu standardowym δ, FSPL(f, δo ) reprezentuje stratę ścieżki, gdy częstotliwość jest stała, a odległość odniesienia do , a n to PLE (wykładnik utraty ścieżki). Ogólnie rzecz biorąc, wartość do znajduje się w polu dalekim, a d powinno być znacznie większe niż do. W przypadku niskiej częstotliwości na zewnątrz do wynosi zazwyczaj 0,1 ˜ 100 km, ale w przypadku środowiska wewnętrznego o wysokiej częstotliwości do wynosi zwykle 1 m. Model CI jest określany tylko przez PLE, a do dopasowania danych zwykle stosuje się metodę najmniejszych kwadratów. SF (zanikanie cieni) można wyrazić przez odchylenie standardowe zmierzonych danych, zdefiniowane w następujący sposób:

jest zmienną losową o średniej zerowej Gaussa opartą na odchyleniu standardowym δ, FSPL(f, δo ) reprezentuje stratę ścieżki, gdy częstotliwość jest stała, a odległość odniesienia do , a n to PLE (wykładnik utraty ścieżki). Ogólnie rzecz biorąc, wartość do znajduje się w polu dalekim, a d powinno być znacznie większe niż do. W przypadku niskiej częstotliwości na zewnątrz do wynosi zazwyczaj 0,1 ˜ 100 km, ale w przypadku środowiska wewnętrznego o wysokiej częstotliwości do wynosi zwykle 1 m. Model CI jest określany tylko przez PLE, a do dopasowania danych zwykle stosuje się metodę najmniejszych kwadratów. SF (zanikanie cieni) można wyrazić przez odchylenie standardowe zmierzonych danych, zdefiniowane w następujący sposób:

gdzie N oznacza liczbę ścieżek między nadajnikiem a odbiornikiem, a δ oznacza odchylenie standardowe mierzonych danych. W procesie propagacji bezprzewodowej na zewnątrz fale elektromagnetyczne są blokowane przez budynki i topografię, a za obiektami ekranującymi tworzy się półślepy obszar. Mechanizm propagacji fal elektromagnetycznych zmieni się ze względu na zmianę tych niepewnych czynników. W procesie transmisji bezprzewodowej w pomieszczeniach główna okluzja pochodzi ze ścian, ludzi itp. Dlatego blaknięcie cienia będzie miało bezpośredni wpływ na zasięg sieci bezprzewodowej i jakość komunikacji.

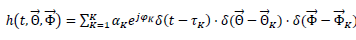

Model propagacji na małą skalę

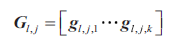

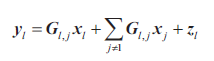

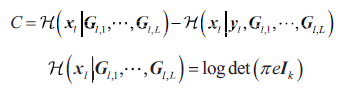

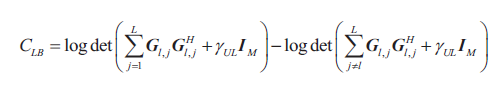

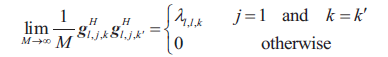

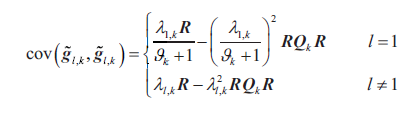

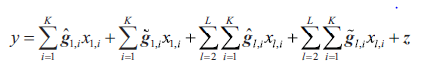

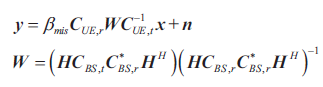

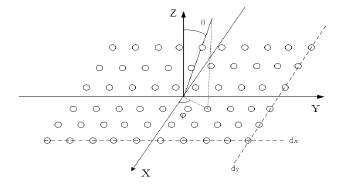

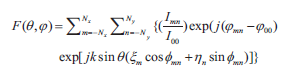

Celem małoskalowego modelu propagacji jest scharakteryzowanie małoskalowych charakterystyk zaniku fal elektromagnetycznych przy szybkich zmianach natężenia sygnału w małym zakresie. Zanikanie na małą skalę odnosi się do szybkiej zmiany odbieranego sygnału w krótkim czasie lub niewielkiej odległości, a zanikanie na małą skalę jest również nazywane szybkim zanikaniem. Przesyłany sygnał rozchodzi się wieloma ścieżkami i dociera do odbiorcy w oparciu o różne mechanizmy propagacji. W tym momencie odbierany sygnał to zestaw sygnałów o różnych amplitudach i fazach przesyłanych różnymi ścieżkami, a sygnały te będą się wzajemnie zakłócać, powodując zanikanie na małą skalę. Sygnał propagowany przez wiele ścieżek nazywany jest sygnałem wielościeżkowym, a sygnał wielościeżkowy ma różną siłę sygnału i szerokość pasma sygnału w procesie propagacji. W przypadku pasma częstotliwości mmWave z jednej strony selektywność częstotliwości kanału bezprzewodowego mmWave jest poważniejsza niż w przypadku niskich częstotliwości i istnieją różnice w charakterystyce zanikania na małą skalę między różnymi pasmami częstotliwości. Z drugiej strony zdolność penetracji sygnału mmWave jest słaba, a transmitowany sygnał może być odbierany w środowisku NLOS (bez linii wzroku). Aby uzyskać pokrycie obszaru NLOS, konieczne jest zbadanie małoskalowych charakterystyk dyspersji kątowej sygnału mmWave. W modelu kanału mmWave geometryczny model kanału oparty na przestrzeni zwykle wykorzystuje CIR (Channel Impulse Response) do odzwierciedlenia małoskalowych charakterystyk kanałów wielościeżkowych, a w pomiarach propagacji radiowej parametry propagacji w małej skali są często wyodrębniane na podstawie CIR sygnałów wielościeżkowych. Model odpowiedzi impulsowej kanału wielościeżkowego mmWave można przedstawić jako funkcję kąta czasowego i przestrzennego

gdzie K jest liczbą wielodrogowości, t oznacza czas, αK, φK i τK oznaczają odpowiednio amplitudę, fazę i względne opóźnienie propagacji wielodrogowości K i oznaczają odpowiednio  i

i  oznaczają kąt odjazdu i kąt nadejścia, z których oba zawierają informacje o kącie poziomym i kącie nachylenia.

oznaczają kąt odjazdu i kąt nadejścia, z których oba zawierają informacje o kącie poziomym i kącie nachylenia.  reprezentuje wektor (θrx, ψrx) złożony z AoD (kąt azymutalny odlotu) i EoD (kąt elewacji odlotu) wielodrogowego K, a Φ reprezentuje wektor (θrx, ψrx) złożony z AoA (kąt azymutalny przybycia) i EoA (Kąt wzniesienia nadejścia) wielodrogowego K.

reprezentuje wektor (θrx, ψrx) złożony z AoD (kąt azymutalny odlotu) i EoD (kąt elewacji odlotu) wielodrogowego K, a Φ reprezentuje wektor (θrx, ψrx) złożony z AoA (kąt azymutalny przybycia) i EoA (Kąt wzniesienia nadejścia) wielodrogowego K.

Model kanału fal milimetrowych

Model kanału jest podstawą projektowania systemów komunikacji bezprzewodowej i oceny technologii algorytmów komunikacyjnych. Dlatego dokładne modelowanie kanałów jest bardzo ważne dla komunikacji bezprzewodowej. Aby zasymulować rzeczywisty proces transmisji sygnału i podsumować charakterystykę kanału, konieczne jest wykonanie dużej liczby pomiarów na typowych scenach, aby uzyskać efektywne wsparcie danych i zwiększyć wiarygodność wyników. Obecnie większość metod modelowania kanałów mmWave to metoda klastra czasu i płata przestrzennego, a także metoda modelu kanału oparta na technologii śledzenia promieni. Niektóre niezwykłe cechy fal milimetrowych są wprowadzane jako ważne odniesienie w procesie modelowania. Na przykład fala milimetrowa reprezentowana przez 60 GHz znajduje się właśnie na szczycie absorpcji tlenu i pary wodnej, a sygnał fali elektromagnetycznej rozchodzi się w atmosferze na dużą odległość. Niektóre badania wykazały, że tłumienie sygnału 60 GHz na niektórych materiałach jest znacznie wyższe niż w przypadku sygnału o niskiej częstotliwości, a tłumienie również różni się w zależności od materiałów. Oprócz powyższych cech, istnieją jeszcze dwie ważne cechy fal mm. Po pierwsze, fala mmWave jest łatwiejsza do zablokowania przez ludzkie ciało i powoduje znaczne tłumienie. Tymczasem kanał mmWave jest niestacjonarny, ze względu na stosunkowo częstą i złożoną działalność człowieka. Po drugie, na podstawie dużej liczby zmierzonych danych stwierdzono, że fala milimetrowa przedstawia istotne cechy zjawiska nadejścia klastra. Dlatego wiele standardów dotyczących modelu kanału mmWave przyjmuje tę funkcję jako podstawę modelowania. Obecnie istnieją trzy międzynarodowe standardy dla modelu kanału mmWave, którymi są IEEE802.15.3c, IEEE802.11ad i ECMA-387. Modele kanałów wysokiej częstotliwości, które zostały ukończone i są w toku, obejmują głównie modele kanałów proponowane przez instytucje badawcze, różne grupy projektów badawczych i organizacje normalizacyjne, a także te proponowane przez 3GPP. Sojusz WiGig jest zaangażowany w badania nad systemami WLAN 60 GHz i wprowadził odpowiedni model kanału IEEE802.11ad w 2009 roku. Model obsługuje trzy scenariusze: sala konferencyjna, kabina i pokój dzienny. Utrata ścieżki i parametry na małą skalę każdej sceny w LOS (Linia widzenia) / NLOS są podane szczegółowo. W modelu tym, zgodnie z charakterystyką propagacji fal elektromagnetycznych 60 GHz w pomieszczeniach, wprowadza się koncepcję klastra, ustala się model blokowania przez człowieka i ustala się prawdopodobieństwo blokowania klastra. Odblokowany klaster musi generować parametry, takie jak czas, amplituda, faza i charakterystyka polaryzacji subśrednicy w klastrze. Ponadto zmodyfikowany model udostępnia trzy rodzaje modeli anten: antena dookólna, antena sterowana kierunkowo i antena z układem fazowym.

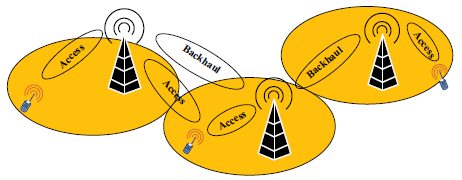

Model kanału MiWEBA

Projekt badawczy MiWEBA poświęcony jest badaniom i rozwojowi heterogenicznych sieci mmWave, które łączą stacje bazowe mmWave UWB z sieciami komórkowymi poprzez backhaul/forward. Celem projektu jest 1000-krotne zwiększenie przepustowości sieci i rozwiązanie problemu ograniczenia przepustowości przy rozsądnych kosztach. Piąta grupa robocza projektu jest odpowiedzialna za pomiary i badania modelu kanału mmWave oraz opracowuje własny model kanału pasma mmWave. Model kanału MiWEBA jest oparty na modelu kanału 3GPP 3D. Dane pomiarowe i metody statystyczne RT (Ray Tracing) są wykorzystywane do opracowania modelu kanału, z naciskiem na testowanie modelu utraty ścieżki w paśmie 57 GHz ~ 66 GHz. Ponieważ ograniczone działania pomiarowe nie mogą skutecznie rozwiązać problemów, takich jak utrata roślinności i blaknięcie cienia powodowanego przez pojazdy mobilne, w ramach projektu MiWEBA opracowano nową dokładną (quasi-deterministyczną, Q-D) metodę modelowania kanałów zewnętrznych i wewnętrznych 60 GHz. Odpowiedź impulsowa kanału mmWave modelu składa się z kilku deterministycznych silnych promieni (promieni D) i wielu stosunkowo słabych promieni losowych (promienie R). Struktura modelu kanału może elastycznie opisywać cechy geometryczne sceny: tłumienie i rozpraszanie odbić, blokowanie promieni i efekty ruchu. W propozycji projektu MiWEBA zdefiniowano trzy główne scenariusze: tereny otwarte (kampusy uniwersyteckie), ulice i lobby hotelowe. Model charakteryzuje się dużą wszechstronnością, a odpowiednie parametry modelu łącza są wybierane na podstawie eksperymentalnych pomiarów i modelowania ray tracingu zgodnie z wymaganiami. Na przykład, zmiana parametrów anteny Tx może zostać rozszerzona na łącze D2D (Device to Device).

Model kanału METIS

W porównaniu z innymi zespołami projektowymi, projekt METIS (Mobile and wireless communication Enablers for the Twenty-twenty Information Society) opracowuje nowe modele kanałów w oparciu o szeroki zakres działań pomiarowych i analiz, uzupełnionych symulacjami komputerowymi. Modele kanałów METIS obejmują modele oparte na mapach, modele losowe lub kombinację tych dwóch modeli, które zapewniają elastyczną i skalowalną strukturę modelu kanału, aby spełnić różnorodne wymagania symulacyjne pod względem dokładności i złożoności obliczeniowej. Model mapy to model śledzenia promieni oparty na uproszczonej mapie, która obejmuje ważne mechanizmy propagacji, takie jak dyfrakcja, odbicie zwierciadlane, odbicie rozproszone, blokowanie i tak dalej. W związku z tym, ze względu na fakt, że model zapewnia dokładne i rzeczywiste charakterystyki przestrzenne kanału, nadaje się do wielkoskalowego modelu utraty ścieżki MIMO i D2D. Model stochastyczny jest oparty na geometrycznym modelu kanału losowego wyewoluowanym z modelu kanału WINNER/3GPP. Dostarczone parametry statystyczne mają charakterystykę fal milimetrowych, a model strat ścieżki jest zależny od częstotliwości. Model hybrydowy ma elastyczną i skalowalną strukturę modelu, która może skutecznie zrównoważyć złożoność i dokładność symulacji. Na przykład zanikanie cieni może być oparte na modelu mapy, podczas gdy zanikanie na małą skalę może być oparte na modelu losowym.

Model kanału Uniwersytetu Nowojorskiego

Zespół profesora Rappaporta z New York University po raz pierwszy ogłosił zewnętrzny dwuwymiarowy model kanału mmWave (28 GHz) w 2014 roku. Model oparty jest na strukturze modelu kanału 3GPP i wykorzystuje dane pomiarowe oraz metody statystyczne ray tracingu do opracowania modelu kanału. . Scenariusze testowe znajdują się głównie w centrum miasta, kampusie, w pomieszczeniach i na zewnątrz pod gęstym miastem (obszar Nowego Jorku na Manhattanie). Następnie zespół zaproponował trójwymiarowy model kanału oparty na losowej geometrii. Parametry wielkoskalowe i małoskalowe w modelu spełniają różne rozkłady losowe (podobne do 3GPP). Model definiuje dwa parametry o małej skali, klastry w dziedzinie czasu i płaty przestrzenne. Liczba klastrów i podścieżek w każdej scenie jest równomiernie rozłożona. Liczba płatów przestrzennych jest zgodna z rozkładem Poissona, a pozostałe parametry kanału są zbliżone do 3GPP. Ponadto model zapewnia trzy modele strat ścieżki do łączenia wiązek, kierunkowy i dookólny. Zaproponowany przez ten zespół model kanału dotyczy tylko mierzonych pasm częstotliwości (28 GHz, 38 GHz, 60 GHz, 73,5 GHz) i nie dostosowuje się do wszystkich pasm częstotliwości od 6 GHz do 100 GHz.

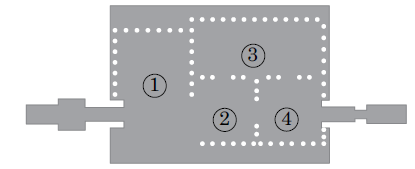

Model kanału mmMAGIC

mmMAGIC (Millimetre Wave Based Mobile Radio Access Network for Fifth Generation Integrated Communications) opracował model kanału wysokiej częstotliwości dla zakresu częstotliwości 6 GHz ~ 100 GHz i przeprowadził 20 rodzajów środowisk propagacji (bloki miejskie, otwarte place, w biurach wewnętrznych, na lotniskach oraz w pomieszczeniach i na zewnątrz) w ośmiu pasmach częstotliwości od 6 do 100 GHz. Model kanału mmMAGIC został opracowany równolegle z 3GPP i ITU-R, a niektóre metody rozwoju zostały przyjęte przez te ostatnie. Model oparty jest na geometrycznym modelu losowym i składa się z modelu podstawowego oraz modelu dodatkowego. Wśród nich funkcje dodatkowego modelu obejmują: efekty odbicia i blokowania gruntu, duże pasmo i duże szyki antenowe, spójność przestrzenną i modelowanie strat penetracji budynku. Schemat pomiarowy mmMAGIC jest podobny do schematu METIS. Ponieważ dane pomiarowe są ograniczone statystycznie, dodatkowe dane kanału są generowane poprzez symulację ray tracingu, a następnie wyniki pomiarów są kalibrowane, aby można było wyprowadzić dodatkowe parametry do modelowania losowego.

Model kanału 5GCM

5GCM (5G Channel Model) to sojusz modeli kanałów 5G mmWave zainicjowany przez NIST (National Institute of Standards and Technology), w tym AT&T, China Mobile, Ericsson, Huawei, Intel, Nokia, Qualcomm, Samsung, New York University, University of Południowa Kalifornia oraz inne instytucje badawcze i uniwersytety. Model ten jest oparty na trójwymiarowym modelu kanału w 3GPP TR 36.873, wykorzystując kombinację wieloczęstotliwościowego pomiaru kanału i symulacji śledzenia promieni. Typowe scenariusze obejmują UMa (Urban Macro), UMi (Urban Micro), InH (Indoor Hotspot) i O2I (Outdoor to Indoor). Oprócz modelu utraty ścieżki, model posiada wiele metod i wartości parametrów zgodnych ze standardem 3GPP TR 38,901. Dla strat przenikania O2I, dla budynków ze ścianami zewnętrznymi o różnym tłumieniu, podane są dwa modele, niski i wysoki. Model ten dostarcza ważnych sugestii referencyjnych dla realizacji spójności przestrzennej. Wraz ze zmianą położenia geometrycznego, realizacja kanałowa parametrów wielkoskalowych i małoskalowych musi być ciągła. Po pierwsze, utrata ścieżki, w tym zanikanie cieni, powinna zmieniać się płynnie wraz z ruchem UT. Po drugie, parametry o małej skali, takie jak kąt, moc i opóźnienie, również powinny zmieniać się dynamicznie wraz z pozycją, co ma ogromne znaczenie dla oceny mobilności i śledzenia wiązki w komunikacji 5G.

Model kanału wysokiej częstotliwości 3GPP

W 2016 roku Organizacja Standardów 3GPP wydała model kanału wysokiej częstotliwości 3GPPTR38.900, który jest rozszerzoną wersją trójwymiarowego modelu 3GPPTR36.873 w zakresie częstotliwości 6 cm 100 GHz. Obsługuje scenariusze takie jak UMi, UMa, InH i dodaje nowe charakterystyki kanałów w scenariuszach 5G, w tym spójność przestrzenną, agregację wielu nośnych, utratę tlenu, odbicie od ziemi, dużą przepustowość i duży układ anten. Model ten dziedziczy metodę modelowania blokowania 5GCM, dodatkowo udoskonala wyrażenie współrzędnych biegunowych i dzieli blokujące obiekty na dwa typy. Dodatkowo zaproponowano dwa uproszczone modele do symulacji połączeń: CDL i TDL. Są bardziej elastyczne niż uproszczony model w WINNERII / SCME i mogą ustawiać rozszerzenie opóźnienia lub rozszerzenie kąta zgodnie z wymaganiami symulacji. Wreszcie model hybrydowy mapy w METIS służy jako odniesienie. W 2017 roku Organizacja Normalizacyjna 3GPP wydała ulepszoną wersję standardu 3GPPTR38.901, który łączy modele kanałów o niskiej i wysokiej częstotliwości oraz rozszerza zakres częstotliwości do 0,5˜100GHz.

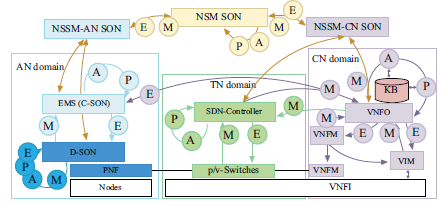

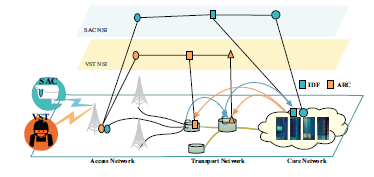

Niedobór istniejącego kanału fal milimetrowych i jego przyszły trend rozwoju

Wszystkie powyższe modele kanałów są oparte na paśmie wysokich częstotliwości, które mogą spełniać charakterystykę transmisji wielkoskalowego systemu MIMO na falach milimetrowych. W 5G i wcześniejszych systemach komunikacyjnych, znormalizowany model kanału ma tendencję do bycia ogólną ramą modelu kanału opartą na strukturze geometrycznej, która wykorzystuje różne parametry do opisywania różnych scenariuszy. Obecnie wszystkie modele kanałów ze standardowymi falami mm są przeznaczone tylko dla naziemnych sieci komunikacyjnych i wymagają dalszej rozbudowy, aby spełnić wymagania aplikacji pełnego zasięgu 6G. Ponadto, ze względu na nowe wymagania aplikacji i wymagania techniczne, kanał fal 6G mm musi wprowadzić nowe wskaźniki wydajności, takie jak wyższa wydajność widmowa / efektywność energetyczna / efektywność kosztowa, wyższa szybkość transmisji, mniejsze opóźnienia, większa gęstość połączeń, zasięg, inteligentne stopień, bezpieczeństwo itp. W celu spełnienia powyższych wymagań i wskaźników wydajności przyszłych aplikacji komunikacji mobilnej, bezprzewodowa sieć komunikacyjna 6G przyjmie nowe zmiany paradygmatu i będzie polegać na nowych technologiach wspomagających. Nowe zmiany paradygmatu można podsumować jako cztery trendy: zasięg globalny, całe spektrum, pełne zastosowanie i silne bezpieczeństwo. Aby zapewnić globalny zasięg, bezprzewodowa sieć komunikacyjna 6G rozszerzy się z lądowej komunikacji mobilnej na zintegrowaną sieć kosmiczną, powietrzną, naziemną i morską, w tym sieć komunikacji satelitarnej, UAV, naziemne sieci ultragęste, komunikację podziemną, komunikację morską i podwodną akustykę sieć komunikacyjna. Aby spełnić wymagania aplikacji dotyczące ultrawysokiej szybkości transmisji i ultrawysokiej gęstości połączeń, całe widmo, w tym sub-6 GHz, fala mm, teraherc i pasmo optyczne, zostanie w pełni zbadane. Sztuczna inteligencja (AI) i big data zostaną zintegrowane z bezprzewodową siecią komunikacyjną, aby lepiej zarządzać siecią komunikacyjną. Co więcej, sztuczna inteligencja może lepiej dynamicznie aranżować zasoby sieciowe, pamięci podręcznej i obliczeniowej, aby poprawić wydajność systemu. Wreszcie przy projektowaniu sieci należy wziąć pod uwagę czynniki bezpieczeństwa, zwane wbudowanymi zabezpieczeniami sieci, w tym zabezpieczenia warstwy fizycznej i zabezpieczenia warstwy sieci. Silne bezpieczeństwo znajduje odzwierciedlenie w projektowaniu sieci jednocześnie z uwzględnieniem czynników bezpieczeństwa, określanych również jako zabezpieczenia endogeniczne sieci, w tym zabezpieczenia warstwy fizycznej i zabezpieczenia warstwy sieci. Dlatego wyprowadzenie nowego ogólnego modelu kanału 6G będzie trudniejsze. Ze względu na niejednorodną charakterystykę kanału bezprzewodowego 6G i różną skalę działania fal radiowych, sposób wykorzystania ogólnej struktury modelu kanału komunikacji 6G mmWave do dokładnego opisania kanału bezprzewodowego 6G staje się trudnym i znaczącym problemem.

Przebieg fali milimetrowej w komunikacji mobilnej

Wraz z nadejściem ery komunikacji mobilnej nowej generacji, szybki wzrost danych użytkowników sprawia, że ludzie rozważają wykorzystanie pasma nośnego powyżej 6 GHz w celu spełnienia wymagań wysokiej przepustowości. Pasmo wysokich częstotliwości koncentruje się na paśmie fal submilimetrowych i paśmie mmWave między 6 ˜ 100 GHz, co ma na celu zapewnienie większą przepustowość komunikacyjną i mniejszą ekspansję opóźnień. Konstrukcja fali nośnej pasma mmWave wciąż stoi przed poważnymi wyzwaniami. Tłumienie ścieżki i efekt Dopplera w nośnej wysokiej częstotliwości oczywiście wzrastają, a sprzęt systemu przetwarzania sygnału będzie miał nieliniowy wpływ na nośną wysokiej częstotliwości. Efekt wysokiej częstotliwości urządzeń sprzętowych i szerokości pasma sygnału oraz inne powiązane czynniki muszą być jednocześnie w pełni uwzględnione przy projektowaniu sprzętu odbiorczego i sprzętu nadawczego, ze względu na znaczny wzrost częstotliwości nośnej. Nie ma wątpliwości, że anteny macierzowe na dużą skalę mogą lepiej spełniać wymagania dotyczące wydajności widmowej wysokich częstotliwości

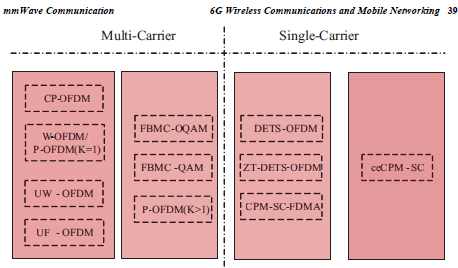

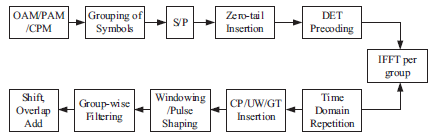

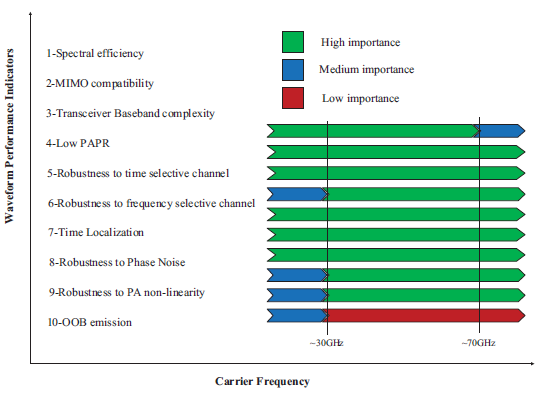

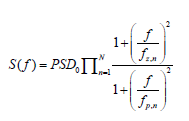

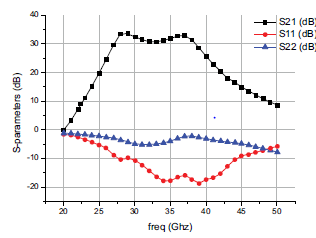

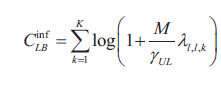

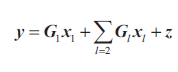

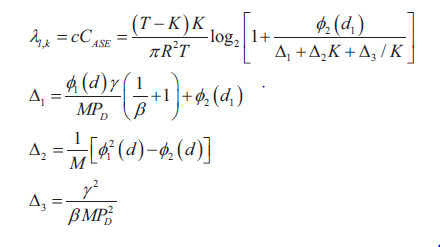

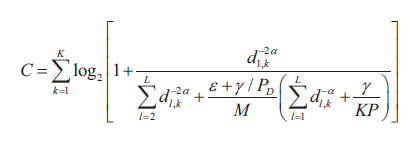

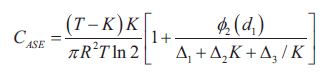

Wydajność fal kandydujących w paśmie wysokiej częstotliwości komunikacji mobilnej